| HIFI-FORUM » Fernseher & Beamer » LCD-Fernseher » Sony » UHD 60 Hz 4:2:0 kein 10/12 Bit über HDMI | |

|

|

||||

UHD 60 Hz 4:2:0 kein 10/12 Bit über HDMI+A -A |

||

| Autor |

| |

|

Robert_N

Ist häufiger hier |

#1

erstellt: 18. Okt 2016, 11:26

|

|

|

Hallo liebe Community, mein Sony ZD9 hängt über HDMI 2.0 (Port 2) an meinem PC (Windows 10 1607, Titan Xp). Ich habe den Sony über das optimierte Format dazu gebracht Deep Colour zu unterstützen. Jedoch kann ich bei UHD@60 Hz weder bei 4:4:4, noch bei 4:2:0 noch bei 4:2:2 mehr als 8 Bit Farbtiefe auswählen in den Nvidia Einstellungen. Unter 1080p ist 12 bit möglich. Ich habe bereits 2 unterschiedliche 18 Gbit/s HDMI Kabel genutzt, unter anderem das, was bei dem Panasonic Blu Ray Player mitgeliefert wird. Hat einer eine Idee woran das liegen kann? Nur 8 Bit Farbtiefe schneidet sich doch irgendwie mit der HDR Darstellung. Z.B. habe ich in Shadow Warrior 2 im HDR Modus im Himmel richtig fieses Color Banding. Es kann zwar ein wenig mit der verbesserten Farbabstufung behoben werden vom Sony aber das ist ja auch nicht Sinn der Sache. |

||

|

hagge

Inventar |

#2

erstellt: 18. Okt 2016, 14:20

|

|

|

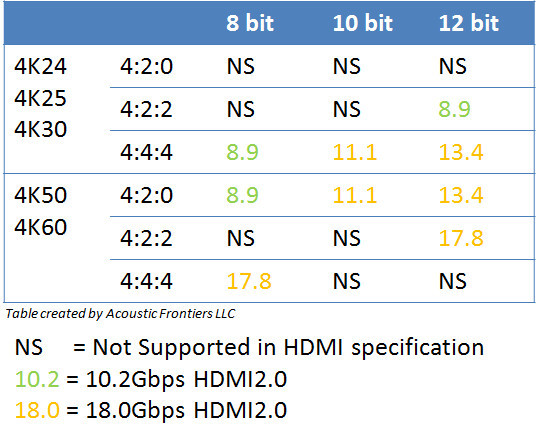

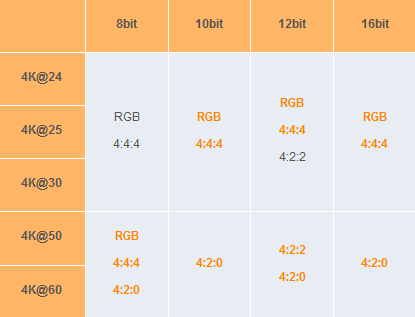

UHD mit 60Hz geht auf HDMI2.0 entweder nur mit 8 Bit/Farbe und 4:4:4 bzw. RGB, oder mit mehr als 8 Bit/Farbe, aber dann kein 4:4:4 bzw RGB mehr. Siehe  hier. Wobei 4:2:0 eigentlich gehen müsste. hier. Wobei 4:2:0 eigentlich gehen müsste.Bezüglich der Farbabrisse, hast Du mal RGB versucht, also nicht irgendein YUV-Format? Eigentlich ist das ja der übliche Weg, Bilder vom PC zum Bildschirm zu bekommen. Dass die Nvidia-Karten hier auch YUV anbieten, ist ja eher ungewöhnlich. Gruß, Hagge [Beitrag von hagge am 18. Okt 2016, 14:24 bearbeitet] |

||

|

|

||

|

Robert_N

Ist häufiger hier |

#3

erstellt: 18. Okt 2016, 14:23

|

|

|

Hallo Hagge, vielen Dank für deine Antwort. Leider ist mein großes Problem, dass ich selbst mit 4:2:0 kein 10/12 bit im Nvidia Control Center einstellen kann. Ich würde definitiv von 4:4:4 runtergehen auf 4:2:0. Aber die Option für mehr als 8 Bit ist nicht verfügbar. Nur in 1080p gibt es diese Option für mich. Wie gesagt Deep Colour ist am TV aktiviert. Muss man da noch was in den Nvidia Settings aktivieren? Ich habe RGB noch nicht versucht eil da ja auch nur 8 Bit gehen. Da könnte ich immerhin die Full Einstellung wählen nicht limited. YUY sind doch die YCbCr 4:4:4 oder? Ich habe wie RGB und die 3 YCbCr Einstellungen zur Auswahl. [Beitrag von Robert_N am 18. Okt 2016, 14:26 bearbeitet] |

||

|

hagge

Inventar |

#4

erstellt: 18. Okt 2016, 14:25

|

|

|

Hups, da warst Du schnell. Ich hab oben nochmal ein bisschen nacheditiert. Hagge |

||

|

Robert_N

Ist häufiger hier |

#5

erstellt: 18. Okt 2016, 14:28

|

|

|

Alles klar, trotzdem danke für deine Antwort. Ich muss mal testen ob bei RGB dann auch der HDR Mode von Shadow Warrior 2 funktioniert. Mir werden die 3 YCbCr Varianten auch erst angeboten, nachdem ich die Deep Colour Einstellung am TV aktiviert habe. |

||

|

Herrgoettle

Inventar |

#6

erstellt: 20. Okt 2016, 09:02

|

|

|

ich hab genau das gleiche problem jedoch mit einer gtx 1060. die lösung ist auf yuv 4:2:2 umzustellen,da geht dann auch 8/10 und 12bit bis 4k 60hz. finde persönlich die treiberlösung von nvidia schlecht gelöst denn yuv 4:2:0 mit 10bit und 4k@60hz geht nicht jedoch gibt es genug videos die genau so aufgenommen sind,da sollte nvidia dringendst nachbessern. |

||

|

Robert_N

Ist häufiger hier |

#7

erstellt: 20. Okt 2016, 09:30

|

|

|

Hallo Herrgoettle, nichtmal 4:2:2 geht bei mir mit 10/12 bit. Ich kann es nicht anwählen. Ich habe gestern versucht meine Informationen des Monitors mit Entech MonInfo auszulesen und die Inf zu modden. Im neogaf konnten somit einige das Farbtiefe probleme am Sony fixxen:  http://www.neogaf.co...511165&postcount=895 http://www.neogaf.co...511165&postcount=895Bei mir geht das nicht. Der ZD9 schickt bei mir das Signal, dass 1080p die native Auflösung ist. Irgendwas funktioniert da nicht in der Kommunikation zwischen dem ZD9 und der Titan Xp. Im Nvidia Control Panel steht neben der Auflösung 1080p Nativ. UHD geht auch natürlich auszuwählen aber da stimmt was nicht :=( |

||

|

Herrgoettle

Inventar |

#8

erstellt: 20. Okt 2016, 09:52

|

|

|

danke für den link,da werde ich mich mal ran wagen - hab mich gestern schon wie blöd gesucht wegen ner lösung und daher nur die yuv4:2:2 variante als lösung gefunden  hat deine titan hdmi 2.0,hdmi 2.0 kabel verwendet,hdmi modus im tv auf erweitert und den dynamischen bereich im tv auf begrenzt gestellt,ist dein tv direkt angeschlossen? sollte eigentlich gehen,wobei bei mir noch ein denon avr-x1200 dazwischen hängt. [Beitrag von Herrgoettle am 20. Okt 2016, 09:53 bearbeitet] |

||

|

Robert_N

Ist häufiger hier |

#9

erstellt: 20. Okt 2016, 09:57

|

|

|

Ja die Titan X(Pascal vom August 2016) hat HDMI 2.0 und Deep Colour ist am TV aktiviert. Der ZD9 macht das am HDMI Input 2 und 3. Ich habe 2 HDMI 2.0 Kabel getestet. Eins von Amazon und eins vom Panasonic UHD Blu Ray Player. 4K@60hz mit 4:4:4 8 Bit gehen. Aber 4:2:0 oder 4:2:2 mit 10/12 bit nicht. Ich habe die Option einfach nicht zum anwählen. Shadow Warrior 2 startet auch im HDR Modus und am TV ist dann der Hinweis dass HDR aktiviert ist. Es sieht auch klasse aus, viel besser als ohne den HDR Modus. Das Problem ist nur das extreme Colour Banding im Himmel. Ich kann das eleminieren mit der Funktion "Weiche Übergänge" am ZD9 aber das ist ja nicht der Sinn der Sache. Es muss ja 10 bit gehen. Nur kann ich es einfach nicht anwählen :=( Der Dynamische Bereich im TV ist auf automatisch eingestellt. [Beitrag von Robert_N am 20. Okt 2016, 09:58 bearbeitet] |

||

|

Herrgoettle

Inventar |

#10

erstellt: 20. Okt 2016, 10:01

|

|

|

hmm,merkwürdig. dann weiss ich auch nicht weiter ausser mal den nvidia treiber komplett neu aufzusetzen,vielleicht liegt es aber auch einfach am tv - würde mich bei sony nicht wundern  |

||

|

Robert_N

Ist häufiger hier |

#11

erstellt: 20. Okt 2016, 10:06

|

|

|

Den Treiber habe ich leider schonmal neu installiert :=(. Das wäre bitter wenn der ZD9 das nicht hinbekommt mit der Kommunikation mit dem PC. Das schaffen selbst irgendwelche mittelklasse TVs. Ich verstehs einfach nicht :=( |

||

|

Herrgoettle

Inventar |

#12

erstellt: 20. Okt 2016, 11:15

|

|

|

les doch einfach mal die edid vom xd mit moinfo aus - dann siehst du was der tv an die grafikkarte übermittelt. das bei mir zb kein 10 bit 4:2:0 geht liegt am denon da laut moninfo in der edid 4:2:0 fehlt - 4:2:2 in 8/10/12 bit ist jedoch in der edid vorhanden. [Beitrag von Herrgoettle am 20. Okt 2016, 11:17 bearbeitet] |

||

|

Robert_N

Ist häufiger hier |

#13

erstellt: 20. Okt 2016, 11:51

|

|

|

Das habe ich gemacht. Da steht zum beispiel drin, dass der TV 1080p als native Auflösung ausgibt. Ich habe dann versucht wie im neogaf Link beschrieben das zu modifizieren aber ich habe nur die Auswahl 1080p. Super seltsam und irgendwie weiss ich nicht weiter ausser den Sony Support zu kontaktieren. |

||

|

Ralf65

Inventar |

#14

erstellt: 22. Okt 2016, 05:45

|

|

|

Nur zur Sicherheit... was meinst Du mit "Deep Colour ist am TV aktiviert" Grundsätzlich sind nur die HDMI Eingänge "2 / 3" am ZD9 UHD/HDR (2160@p60) fähig, aber die nutzt Du ja auch. Um dies zu nutzen, muss unter den "Videooptionen" die Einstellung für den genutzen HDMI Eingang entsprechend angepasst werden "optimiert". Bei mir reichte es allerdings auch aus, alle Einträge auf automatisch zu setzen. HDR-Modus:Autom. HDMI-Videobereich:Autom. Farbraum:Autom. jetzt nutze ich allerdings keine Grafikkarte für die Zuspielung und kann daher auch nicht beurteilen, ob es speziell hier evtl. irgendwelche Besonderheiten (Probleme) im Zusammenspiel gibt. Bei mir lief kurzzeitig nur ein UHD/HDR Mediaplayer am ZD9, dort war soweit ich mich erinnere unter 4K 4.2.0 auswählbar Da ich das Gerät jedoch wieder retoure geschickt habe, kann ich die Einzelheiten jetzt leider nicht mehr detailliert nachvollziehen [Beitrag von Ralf65 am 22. Okt 2016, 05:51 bearbeitet] |

||

|

Robert_N

Ist häufiger hier |

#15

erstellt: 22. Okt 2016, 09:31

|

|

|

Hallo Ralph. Genau das optimierte Format meine ich. Das ist aktiviert und der PC ist am HDMI Port 2. Zum Vergleich der Panasonic UHD Blu ray Player ist an Port 3. Dort geht dann 4k@24p mit ycbcr4:4:4 und 12 Bit. Das kann ich mit Hilfe der Info taste am Blu ray Player sehen. HDR funktioniert definitiv. Am pc auch aber in UHD mit 60 Hz bekomme ich keine 10 oder 12 Bit zur Auswahl. 4:4:4 mit 8 Bit geht jedoch. Das HDR in shadow warrior 2 geht. Der TV geht auch in den HDR Modus. Aber ich habe heftiges colour banding da nur 8 Bit Farbtiefe pro Kanal. |

||

|

Robert_N

Ist häufiger hier |

#16

erstellt: 22. Okt 2016, 13:51

|

|

|

Ok Update in 4:2:2 gehen 10 und 12 Bit Farbtiefe. Ich hab das nochmal überprüft. In 4:2:0 gehen nur 8 Bit Farbtiefe. |

||

|

Ralf65

Inventar |

#17

erstellt: 23. Okt 2016, 04:06

|

|

|

eine Übersicht der unterstützten HDMI Auflösungen aus dem  AVS und der jeweiligen benötigten Datenrate AVS und der jeweiligen benötigten Datenrate [Beitrag von Ralf65 am 23. Okt 2016, 05:48 bearbeitet] |

||

|

hagge

Inventar |

#18

erstellt: 23. Okt 2016, 08:31

|

|

|

Gerade darum verwundert es ja, dass bei 4:2:0 anscheinend nicht alle Varianten mit 60Hz gehen, obwohl in der Tabelle alle Bittiefen erlaubt sind. Aber immerhin: wenn 4:2:2 bei 12 Bit gehen, ist das sowieso die bestmögliche Kombination, die es geben kann. Besser als das Bild in dieser Kombination kann es nicht werden. Und man sieht, dass es auch funktionierende Kombinationen gibt, die offiziell gar nicht definiert sind. Wie 4:2:2 bei 10 Bit. Der Grund, warum 4:4:4 nicht auch bei höheren Bittiefen klappt, ist definitiv die Datenrate. Die ist schon bei 8 Bit am oberen Anschlag. Gruß, Hagge PS: Mal ne zusätzliche Frage weil ich mich das gerade persönlich frage: wie sieht das Datenformat von 4:2:0 über HDMI eigentlich aus? Bei 4:4:4 ist es ja YUV, YUV, YUV für jedes Pixel. Bei 4:2:2 ist es ja YUYV, YUYV, YUYV, also immer zwei Pixel in einer Gruppe. Aber bei 4:2:0? Kommt da dann wirklich immer jede zweite Zeile mit YUYV und die jeweils andere Zeile mit nur Y, Y, Y daher? [Beitrag von hagge am 23. Okt 2016, 08:46 bearbeitet] |

||

|

Herrgoettle

Inventar |

#19

erstellt: 23. Okt 2016, 08:45

|

|

|

ich habe die starke vermutung das es wirklich am nvidia treiber liegt. laut edid,ausgelesen mit moninfo,kann mein denon avr-x1200 kein 4:2:0 dafür jedoch 4:2:2 und 4:4:4 in allen aktuellen bit tiefen und laut edid auch nur bis full-hd obwohl der denon 4k mit hdcp2.2 kann - daher glaube ich der edid nicht wirklich. wenn man jetzt jedoch yuv4:2:0 mit yuv4:2:2 vergleicht ist die 4:2:2 ja die bessere variante da die darstellung unter 4:2:2 genauer ist,verwunderlich ist trotzdem das ganze und irgendwie habe ich wirklich die vermutung das es an dem treiber liegt da bei mir zb. alle geräte mit hdcp2.2 kommunizieren,18gb/s hdmi kabel verwendet werden usw. |

||

|

hagge

Inventar |

#20

erstellt: 23. Okt 2016, 08:51

|

|

Da ich mich neulich zufällig durch einen EDID-Treiber für Linux gewühlt habe, weiß ich, dass es bei EDID eine Grunddatenstruktur gibt, die aber nur eine begrenzte Menge an Auflösungen aufnehmen kann. Darum wurde EDID irgendwann mal erweitert und im Erweiterungsblock können dann weitere Auflösungen untergebracht werden. Vielleicht ruft Deine EDID-Anzeige über I2C nur den Grundblock ab, aber nicht den Erweiterungsblock? Entsprechend siehst Du dann nicht alle möglichen Auflösungen. Gruß, Hagge [Beitrag von hagge am 23. Okt 2016, 08:53 bearbeitet] |

||

|

Herrgoettle

Inventar |

#21

erstellt: 23. Okt 2016, 09:16

|

|

|

das wäre natürlich auch eine möglichkeit - muss ehrlich gestehen das ich mich so genau natürlich jetzt nicht damit beschäftigt habe. |

||

|

Ralf65

Inventar |

#22

erstellt: 23. Okt 2016, 10:15

|

|

auf der spanischen Seite  CineDigital habe ich dazu folgendens gefunden CineDigital habe ich dazu folgendens gefunden [Beitrag von Ralf65 am 23. Okt 2016, 10:17 bearbeitet] |

||

|

hagge

Inventar |

#23

erstellt: 23. Okt 2016, 14:17

|

|

|

Ah, OK, das wäre sinnvoll. Eine Zeile immer YUY, YUY, YUY und die nächste Zeile immer YVY, YVY, YVY. Ja, das wäre glaube ich die sinnvollste Aufteilung, um ungleiche Zeilenlängen zu vermeiden. Danke für die Info. Gruß, Hagge |

||

|

Bow_Wazoo_1

Inventar |

#24

erstellt: 17. Nov 2016, 23:58

|

|

|

Hey Leute  Ich komme eigentlich aus dem KS9590 Lager, aber da ich vor kurzem meine GTX1060 an den TV angeschlossen habe, und mir mir auch eine Runde Shadow Warrior 2 in HDR gönnen will, frage ich mich, welches Ausgabeformat das beste ist, wenn ich mit dem PC am TV Zocken will (ganz unabhängig von Games die HDR unterstützen). Aber 10bit muss ja schon mal sein, wenn das Spiel in HDR laufen soll, das hab ich kapiert. Bin allerdings trotzdem einwenig verwirrt: Einerseits liest man das der Fernseher letztendlch in RGB wandeln muss, andererseits kann man 10 oder 12bit nur bei YCbCr 4222 und 444 auswählen?!  und warum ist 422 12bit besser als 10bit? Der ZD9 und der KS9590 unterstützen doch eh "nur" 10bit?  [Beitrag von Bow_Wazoo_1 am 18. Nov 2016, 00:00 bearbeitet] |

||

|

Robert_N

Ist häufiger hier |

#25

erstellt: 18. Nov 2016, 00:13

|

|

|

Für alle nicht HDR Signale nimm am besten 3840*2160@60hz RGB 8 Bit. Für Shadow Warrior 2 nimm 4:2:0 10 oder 12 Bit. Das ist egal eigentlich. Ich denke der TV kann ein 12 Bit Signal entgegen nehmen muss es dann aber herunterrechnen. Mit 4:2:2 habe ich bei shadow warrior extrem komische Farben und Helligkeit. Das funktioniert irgendwie nicht richtig in dem Game egal ob 10 oder 12 Bit. Mit 4:4:4 kannst du nur 8 Bit wählen. Das ist wie bei RGB da limitiert der HDMI 2.0 Standard bei 4k@60. |

||

|

Bow_Wazoo_1

Inventar |

#26

erstellt: 18. Nov 2016, 00:23

|

|

|

Ja, das hab ich mir für nicht HDR Spiele schon gedacht. Genau mit dieser Einstellung bin ich mommentan mit Crysis3 dran. Bei 4:2:0 kann ich zwischen 8 und 12bit wählen. 10bit geht nur bei 4:2:2. Kommt das Spiel in HDR besser? [Beitrag von Bow_Wazoo_1 am 18. Nov 2016, 00:24 bearbeitet] |

||

|

Robert_N

Ist häufiger hier |

#27

erstellt: 18. Nov 2016, 00:51

|

|

|

Ich finde die Beleuchtung wesentlich realistischer. Leider habe ich das Problem, dass ich in 4:2:0 nur 8 Bit auswählen kann. Warum auch immer. Damit habe ich Colour Banding im Himmel. Mit 4:2:2 10/12 Bit sieht das game hingegen total komisch aus das geht auch nicht :-(. Wähle du mal 4:2:0 12 Bit dann müsste alles ok sein. Schau mal im Himmel ob du da Colour Banding hast. MfG |

||

|

Bow_Wazoo_1

Inventar |

#28

erstellt: 18. Nov 2016, 17:00

|

|

|

Jetzt hat es endlich klick gemacht  Hier passend zum Thema, Zitait PCGHW: "17.11.2016 um 16:45 Uhr UHD und HDR - eine schöne neue Welt kommt da auf die Nutzer zu, aber bei HDR gibt es so ein paar Probleme. Viele vermuten HDMI 2.0a als Übeltäter, dessen Bandbreite für Inhalte in UHD, 60 Hz und YCrBr-4:4:4 zu gering ist. AMD bestätigte, dass man daher bei der Radeon auf 8 Bit pro Kanal reduziert. Das ist unschön, aber offenbar noch der beste Kompromiss, bis Monitore mit Displayport 1.4 und HDR auf dem Markt sind. HDR ist eines der großen Themen, wenn es um die Zukunft der Bildschirmausgabe geht. Gefühlt ist HDR als Thema sogar größer als UHD. Das liegt auch nahe, denn von HDR hat der Nutzer effektiv mehr als von einer noch mal erhöhten Pixelzahl, für die es kaum Inhalte und leistungsfähige Hardware gibt. Unschön ist dabei, dass gerade beim Thema HDR PC-Spieler nicht so gut dastehen, wie man es von der technisch führenden Gaming-Plattform erwarten würde. Nicht nur gibt es aktuell keine UHD-Monitore mit HDR, es klemmt auch an der Unterstützung. AMD bestätigte nämlich nun gegenüber Heise, dass die RX400-Reihe mit Polaris-Chip nur HDR in 8 Bit und nicht in 10 Bit unterstützt. Das klingt nach einer Kleinigkeit, kann aber in der Praxis Probleme verursachen. Kauft sich ein Polaris-Besitzer also einen HDR-tauglichen Fernseher und schließt ihn an, muss dieser mit 8-Bit HDR klar kommen. Tut er das nicht, gibt es Probleme. 10 Bit pro Farbkanal über HDMI 2.0a ist die Königsdisziplin. Bei 8 Bit wird die Farbtiefe reduziert. Immerhin wird der Fernseher ein HDR-Signal von der Radeon RX400 erkennen, da AMD laut Heise ein spezielles Dithering-Verfahren in Bezug auf die Gamma-Kurve ein (Perceptual Curve) einsetzt, um bei Farbverläufen keine unschönen Abstufungen zu erzeugen. Perfekt ist das aber nicht. Auf 10 Bit zu setzen, wäre die technisch schönere Lösung gewesen. Der Grund für das ganze Theater ist übrigens HDMI 2.0a, dass nicht genügend Bandbreite bietet, um ein UHD-Signal mit 10 Bit, 60 Hz und YCrBr-4:4:4 über die Strippe zu schicken. AMD hat sich daher für die 8-Bit-Lösung entschieden, statt die Abtastung zu reduzieren. Das hätte nämlich gerade bei Spielen zu unschönen Darstellungen führen können. Mit Displayport 1.4 hätte man solche Probleme nicht, aber dieser Standard ist ein IT-Standard und findet sich an Fernsehern nicht. Dort setzt man auf HDMI. Monitore mit HDR werden dahingegen frühestens 2017 erwartet. Die große Frage ist nun, ob auch Filme betroffen sind, die in der Regel nur mit 30 Hz ausgespielt werden. Bei Nvidia hat man sich für eine andere Lösung als AMD entschieden. In einer kurzen Stellungnahme bestätigte Nvidia Deutschland uns gegenüber mit dem Verweis auf den HDR-Standard SMPTE 2084, dass man für HDR unter HDMI 2.0a/b "auf 10 Bit und 4:2:2 bzw. 4:2:0 bei 4K60" setze. Über Display Port setzt Nvidia auf 4K60 10 Bit bei 4:4:4. und, ob auch Nvidia ein solches Problem hat, denn die Bandbreitenprobleme von HDMI 2.0a sind für alle gleich. Und auch bei der Playstation 4 Pro mit Polaris-GPU stellt sich die Frage, ob mit 8 oder 10 Bit gearbeitet wird und wann. Was Polaris ohnehin nicht kann, sind Filme mit Dolby Vision (12 Bit pro Farbkkanal). Hier muss man entsprechende Hardware kaufen, die dies unterstützt. Zudem droht derzeit ein Wildwuchs der HDR-Standards, weil auch noch andere Unternehmen an Lösungen basteln...."  http://www.pcgamesha...en-HDMI-20a-1213648/ http://www.pcgamesha...en-HDMI-20a-1213648/ [Beitrag von Bow_Wazoo_1 am 18. Nov 2016, 17:01 bearbeitet] |

||

|

Bow_Wazoo_1

Inventar |

#29

erstellt: 18. Nov 2016, 17:04

|

|

|

Letztendlich stellt sich für mich die Frage, ob und welche Qualitätseinbusen man bei 4:2:0 und 4:2:2, im vergleich zu 4:4:4 hat...  |

||

|

Robert_N

Ist häufiger hier |

#30

erstellt: 18. Nov 2016, 17:26

|

|

|

Teste doch mal :-). Mit etwas Abstand vom TV meine ich da keinen großen Unterschied ausmachen zu können. |

||

|

Bow_Wazoo_1

Inventar |

#31

erstellt: 18. Nov 2016, 17:31

|

|

|

Wie denn?  Hdmi 2.0 kriegt doch 4:4:4, 10bit, 60Hz bei 4K nicht hin... |

||

|

Robert_N

Ist häufiger hier |

#32

erstellt: 18. Nov 2016, 17:38

|

|

|

Richtig. Jetzt testet du ein SDR game zb crysis 3 mit 4:4:4 8 Bit, danach mit 4:2:2 8 bit und zu guter letzt mit 4:2:0 8 Bit. Wenn ich dich richtig verstanden hatte wolltest du wissen ob die Reduzierung des Farbsignals auswirkungen auf die Bildqualität hat. Wenn du das einzige HDR game am pc was es zur Zeit gibt (SW2) spielen willst in HDR dann gibt aktuell keine Wahl. Hier geht eh nur 4:2:0 mit 10(12) Bit. Alles andere bringt Fehler. Also musst du dir da keinen Kopf machen ob 4:4:4 oder die anderen beiden Optionen. Weißt du was ich meine? |

||

|

Bow_Wazoo_1

Inventar |

#33

erstellt: 18. Nov 2016, 17:46

|

|

|

Yo, das hab ich schon mal gemacht. Allerdings nicht wirklich ausführlich. Konnte auf die Schnelle keinen Unterschied erkennen. Werds noch mal wiederholen. Ein Displayport am Tv, das wäre fein. Ist das Color Banding bei 4:2:0 denn jetzt weg? Hab SW2 vorhin auf die HDD gepackt. Vieleicht schaffe ich es heute noch zu installiern. Bin gespannt was bei mir zu sehen sein wird.. |

||

|

Robert_N

Ist häufiger hier |

#34

erstellt: 18. Nov 2016, 17:50

|

|

|

Ich meine aus der Entfernung auch keine Unterschiede erkennen zu können in Spielen. Bei Text ist es was anderes. Mein Problem kann ich leider nicht beheben. Bei mir geht 4:2:0 in 4k@60hz nur mit 8 Bit. Eine andere Option bietet mir der Nvidia Treiber nicht. 4:2:2 da kann ich 10/12 Bit auswählen. Das hilft mir leider nicht bei SW2. Naja ich weiss da leider nicht weiter. |

||

|

Bow_Wazoo_1

Inventar |

#35

erstellt: 18. Nov 2016, 18:15

|

|

|

Je mehr ich lese, desto mehr wird mir klar, das es kacke ist das RGB Signal das die Karte vom Renderer bekommt, in YCbCr umzuwandeln  https://www.avforums...-10-bit-hdr.2059833/ https://www.avforums...-10-bit-hdr.2059833/ |

||

|

hagge

Inventar |

#36

erstellt: 18. Nov 2016, 19:01

|

|

|

Vielleicht nochmal ein bisschen Grundwissen. Achtung, das wird nun etwas länger! Es gibt zwei grundsätzlich verschiedene Verfahren, Bilder zu übertragen: RGB und YUV. Letzteres wird manchmal auch als YCbCr bezeichnet, was aber (fast) das Gleiche ist, so dass ich künftig der Einfachheit halber immer YUV sagen werde. RGB Betrachten wir zuerst RGB. RGB steht für Rot/Grün/Blau. Das heißt hier wird für jedes Pixel ein Wert für das rote Subpixel, das grüne Subpixel und das blaue Subpixel übertragen. Das Datenformat stimmt also mit dem Aufbau des Bildschirms überein, der ja auch RGB für die Darstellung der Pixel benutzt. Insofern wäre das eigentlich das natürlichste Format, um Daten vom PC zum Bildschirm zu übertragen. In der Vergangenheit waren hier 8 Bits pro Farbe, also 24 Bits insgesamt üblich. Damit ließen sich pro Farbkomponente 256 Helligkeitsabstufungen darstellen. Will man die Abstufungen feiner haben, dann muss man mehr Bits nehmen. Möglich wären hier 10 Bit pro Farbe (1024 Abstufungen pro Farbe, 30 Bits insgesamt) oder sogar 12 Bit pro Farbe (4096 Abstufungen, 36 Bits insgesamt). Grafikprogramme am PC können zum Teil sogar 16 oder 32 Bits pro Farbe bearbeiten, was dann 48 Bits oder gar 96 Bits entsprechen würde. Solche Bilder lassen sich aber heute noch auf keinem Bildschirm der Welt darstellen. Das Problem mit diesen hohen Auflösungen ist dann aber, dass man natürlich auch mehr Datenrate auf dem Kabel zum Bildschirm benötigt, also z.B. einem HDMI-Kabel. Bei den heute üblichen UHD-Fernsehern, also Bildern mit 3840 x 2160 Pixeln, sind das bei 10 Bit pro Farbe und 60 fps entsprechend 3840 * 2160 * 30 Bits/Pixel * 60 fps = 15 GBit/s Nutzdaten. Und bei 12 Bit pro Farbe entsprechend sogar 18 GBit/s Nutzdaten. Nun ist es aber so, dass das HDMI-Format noch Bitstuffing nutzt, so dass aus jeweils 8 übertragenen Bits 10 Bits auf dem Kabel werden. Wir müssen diese Werte also noch mit 10/8 multiplizieren, um die echte Datenrate auf dem Kabel zu bekommen. Bei 10 Bit pro Farbe sind das also 18,7 GBit/s tatsächliche Daten, bei 12 Bit entsprechend 22,4 GBit/s. Bei HDMI-Kabeln, die für HDMI 2.0 geeignet sind, ist aber 18 GBit/s die Grenze. das heißt diese Formate mit 10 und 12 Bits pro Farbe sind per RGB nicht mehr bei 60 Hz BIldrate möglich, sie überschreiten die maximale Datenrate der Kabel. Bei Display-Port geht es noch, da dort höhere Frequenzen auf dem Kabel definiert und damit möglich sind. Also erste Erkenntnis: RGB geht auf HDMI bei 60 Hz nur mit maximal 8 Bit/Farbe, will man mehr Bit pro Farbe nutzen, kann man maximal 30 Hz erreichen. YUV So, schauen wir uns nun YUV an. In diesem Format werden die Daten anders übertragen. Hier wird ein Helligkeitssignal übertragen (Y) und zwei Farbkomponenten (U und V). Warum macht man das? Das hat mehrere Gründe.

Gerade der letzte Punkt ist sehr wichtig. Man hat (schon zu Analog-TV-Zeiten) festgestellt, dass die Helligkeitsinformation für das menschliche Auge viel wichtiger ist als die Farbinformation. Schon damals hat man darum die Farbe mit einer deutlich geringeren Frequenz übertragen als die Helligkeit. In der digitalen Welt hat man das so gelöst, dass man zwar für jedes Pixel Helligkeitsinformation überträgt, aber nicht unbedingt für jedes Pixel Farbinformation. In diesem Fall werden die gleichen Farbinformationen für mehrere Pixel genutzt. Die gängigsten Farbunterabtastungen sind:

Wer jetzt meint, dass 4:2:0 doch furchtbar schlecht aussehen muss, für den ist es vielleicht interessant zu wissen, das *jede* DVD und *jede* BluRay mit diesem Format arbeitet. Und so schlecht sieht das doch nicht aus, oder? Zweite Erkenntnis: 4:4:4, 4:2:2 und 4:2:0 gibt es nur beim YUV-Format, nicht beim RGB-Format. Datenraten bei YUV Rechnen wir jetzt mal ein bisschen die Datenraten für verschiedene Formate aus: 4:4:4: Hier gibt es für jede Komponente Y, U und V gleich viele Daten: UHD mit 12 Bit/Komponente bei 60 Hz: 3840 * 2160 * 3 * 12 * 60 = 18 Gbit/s, auf HDMI: 18 GBit/s *10 / 8 = 22,4 GBit/s UHD mit 10 Bit/Komponente bei 60 Hz: 3840 * 2160 * 3 * 10 * 60 = 18 Gbit/s, auf HDMI: 15 GBit/s *10 / 8 = 18,7 GBit/s Hier bekommt man also genau die gleichen Datenraten wie bei RGB. Darum klappt es hier genauso wenig mit 60Hz wie bei RGB. 4:2:2: Hier gibt es für U und V jeweils nur die halbe Datenmenge: UHD mit 12 Bit/Komponente bei 60 Hz: 3840 * 2160 * 12 * 60 + 3840 * 2160 * 2 * 12 * 60 / 2 = 12 Gbit/s, auf HDMI: 12 GBit/s *10 / 8 = 15 GBit/s UHD mit 10 Bit/Komponente bei 60 Hz: 3840 * 2160 * 10 * 60 + 3840 * 2160 * 2 * 10 * 60 / 2 = 10 Gbit/s, auf HDMI: 10 GBit/s *10 / 8 = 12,5 GBit/s 4:2:0: Hier gibt es für U und V jeweils nur ein Viertel der Datenmenge: UHD mit 12 Bit/Komponente bei 60 Hz: 3840 * 2160 * 12 * 60 + 3840 * 2160 * 2 * 12 * 60 / 4 = 9 Gbit/s, auf HDMI: 9 GBit/s *10 / 8 = 11,2 GBit/s UHD mit 10 Bit/Komponente bei 60 Hz: 3840 * 2160 * 10 * 60 + 3840 * 2160 * 2 * 10 * 60 / 4 = 7,5 Gbit/s, auf HDMI: 7,5 GBit/s *10 / 8 = 9,3 GBit/s Wie man sieht liegen sowohl für 4:2:2 und natürlich erst recht für 4:2:0 die Werte alle unter der Grenze von 18 GBit/s für HDMI. Das heißt theoretisch wären alle diese Modi auch mit 60 Hz möglich. Dritte Erkenntnis: YUV mit 4:4:4 geht bei HDMI ebenfalls nur mit maximal 30 Hz, 4:2:2 oder 4:2:0 sind aber auch mit 60 Hz möglich. HDMI-2.0-Datenformate Schaut man sich nun die Tabelle der bei HDMI 2.0 erlaubten Datenformate an, wie sieh z.B.  hier zu finden ist, dann sieht man, dass das im Wesentlichen passt. Das einzige, was kurios ist, ist dass für 8 und 10 Bit pro Komponente keine 4:2:2-Formate definiert sind. Ob ein TV diese dann trotzdem schluckt oder nicht, kann man nur durch Tests herausfinden. Offiziell muss er sie nicht können. hier zu finden ist, dann sieht man, dass das im Wesentlichen passt. Das einzige, was kurios ist, ist dass für 8 und 10 Bit pro Komponente keine 4:2:2-Formate definiert sind. Ob ein TV diese dann trotzdem schluckt oder nicht, kann man nur durch Tests herausfinden. Offiziell muss er sie nicht können. Farbräume So kommen wir nun zu den Farbräumen Die Bittiefe, also ob 8, 10 oder 12 Bits pro Farbkomponente übertragen werden, hat nichts damit zu tun, *welche* Farben angezeigt werden. Bei 0 ist bei allen diesen Bittiefen die Farbe ausgeschaltet und beim Maximalwert (255, 1023 oder 4095) bei allen Bittiefen die gleiche maximale Farbe erreicht. Eine Farbe R=0, G=255, B=0 mit 8-Bit pro Farbe erzeugt also beispielsweise genau das gleiche Grün wie R=0, G=4095, B=0 bei 12 Bit Farbtiefe. Welches Grün das aber ist, das wird über den Farbraum festgelegt. Hier gab es früher bei Röhren-TVs und DVDs den REC601, dann später bei HD-TVs und BluRays den REC709, der aber mit REC601 nahezu identisch ist. Das ist auch im Prinzip der gleiche Farbraum, der bei PCs genutzt wird, dort nennt man ihn aber nochmal anders, nämlich sRGB. Die Farben, die damit möglich waren, waren hauptsächlich dadurch definiert, was mit Phosphoren möglich war. Obwohl mit HD-TVs mit LCD-Technik, Plasmas oder OLEDs also teilweise mehr Farben möglich gewesen wären, hat man sich auf die Farben beschränkt, die schon seinerzeit bei den Röhren möglich waren. Im Kino hat man aber ja andere Techniken im Einsatz. Da waren es Beamer, die anders funktionieren. Hier hat man darum von Anfang an bei den digitalen Projektoren auf einen größeren Farbraum gesetzt, den sogenannten DCI-Farbraum. Das heißt im Kino waren in der Vergangenheit tatsächlich andere, buntere Farben möglich als mit DVD und BluRay auf einem TV zu Hause. Wurde ein Film für eine BluRay gemastert, musste also der Farbraum vom Kino-DCI-Farbraum auf den Heim-REC709-Farbraum reduziert werden. Mit den UHD-BluRays wurden nun aber endlich auch andere Farbräume für den Heimgebrauch definiert. Nun gibt es auch den DCI-Farbraum für zu Hause. Wobei sich die TVs da aber noch schwer tun. Nur die besten aktuellen TVs (Stand 2016) erreichen diesen Farbraum gerade so, die meisten TVs schaffen nicht mal diesen DCI-Farbraum. Und es wurde sogar ein noch größerer Farbraum definiert, nämlich der REC2020. Dieser ist so groß, dass auch die besten heutigen Bildschirme noch nicht mal ansatzweise diesen Farbraum anzeigen können, ja noch nicht mal sauteure Studiomonitore. Aber man will mit diesem Farbraum eben gerüstet für die Zukunft sein, wenn neue Fernsehtechniken kommen oder die bisherigen Techniken noch weiter verbessert werden. Was heißt das nun? Wenn man den obigen Wert R=0, G=255, B=0 im DCI-Farbraum anzeigt, dann ist das ein völlig anderes, kräftigeres Grün, als im REC709-Farbraum. Und im REC2020-Farbraum wäre es nochmal ein kräftigeres Grün als im DCI-Farbraum. Es ist also reine Definitionssache, was so ein Farbtripel bedeutet. Je nachdem welchen Farbraum man dazu angibt, sind die erzeugten Farben unterschiedlich. Vierte Erkenntnis: Die Bittiefe hat nichts mit dem Farbraum zu tun. Es ist ohne weiteres möglich, 10 oder 12 Bit Farbtiefe im REC709-Farbraum anzuzeigen, als auch den DCI- oder REC2020-Farbraum nur mit 8 Bit Farbitefe anzuzeigen. Natürlich macht es Sinn, bei größeren Farbräumen auch mit mehr Bittiefe zu arbeiten, weil sonst das Color-Banding stärker wird, also die Farbstufen von Farbe zu Farbe zu grob sind, aber es ist nicht zwingend notwendig. HDR Nun noch zum Schluss HDR. HDR bedeutet, dass man mehr Details in dunklen und hellen Bereichen sehen will. Das bedeutet, der TV muss diese Bereiche feiner differenzieren können. Dazu hat man die Helligkeitsübertragungsfunktion anders definiert. Was das nun im Detail bedeutet, das würde hier nun zu weit gehen, zumal es hier nun auch noch verschiedene Formate gibt (HDR10, Dolby Vision, HLG, etc). Letztendlich heißt das in der Praxis, dass HDR auch einen erweiterten Farbraum nutzt. HDR mit REC709 gibt es also nicht, nur HDR mit DCI oder REC2020. Da ein anderer Farbraum aber nicht automatisch auch eine höhere Bittiefe bedeutet, ist HDR mit 8-Bit pro Farbkomponente ohne weiteres möglich, wenn auch nicht unbedingt sinnvoll. Fünfte Erkenntnis: HDR mit 8 Bit/Farbe ist möglich. UHD Premium Damit ein TV das Label UHD-Premium bekommen kann, sind folgende Bedingungen notwendig:

So, ich weiß, das war extrem viel Informationen auf einmal, aber vielleicht bringt das ja etwas Licht ins Dunkel, warum gewisse Datenformate funktionieren und andere nicht. Viele Grüße, Hagge [Beitrag von hagge am 18. Nov 2016, 19:07 bearbeitet] |

||

|

Robert_N

Ist häufiger hier |

#37

erstellt: 18. Nov 2016, 19:15

|

|

|

Super vielen dank, dass sollte sich jeder der in die Materie einsteigen will lesen. Wie bekomme ich jetzt nur Nvidia und Sony dazu die Kommunikation zwischen Titan Xp und ZD9 besser abzustimmen dass ich 4:2:0 mit 10 oder 12 Bit nutzen kann. Habe beide kontaktiert. Nichts. :-( |

||

|

Bow_Wazoo_1

Inventar |

#38

erstellt: 18. Nov 2016, 19:23

|

|

|

Wenn es einen Gefällt mir Button gäbe, würde ich ihn jetzt drücken!  Sehr coole Zusammenfassung! Die einzige Frage die sich mir jetzt stellt in Hinblick auf 4k HDR Games ist: Würde ich einen Unterschied (und wenn ja welchen) sehen können, wenn mein Tv ein DisplayPort hätte, und ich folgende Ausgangssignale bei HDR Games vergleichen könnte: 1. YCbCr 4:2:2 (oder 0) 10bit und 2. RGB 10bit Momment mal, kann ich diesen Vergleich nicht machen, wenn ich auf 30Hz runtergehe? [Beitrag von Bow_Wazoo_1 am 18. Nov 2016, 19:24 bearbeitet] |

||

|

Robert_N

Ist häufiger hier |

#39

erstellt: 18. Nov 2016, 19:26

|

|

|

Richtig in 30 Hz funktioniert das. Hab ich bereits getestet. Ist für Games nur nicht so gut spielbar :-D. Zum testen geht es. Im shadow warrior wie gesagt geht 4:2:2 nicht. Das Spiel ist dann kaputt. Musst du dir mal ansehen. |

||

|

Bow_Wazoo_1

Inventar |

#40

erstellt: 19. Nov 2016, 20:55

|

|

|

Hab heute SW2 getestet.. Sieht in HDR kacke aus. Helligkeitswerte stimmen nicht.  Banding ist nicht vorhanden, weder bei 4:2:2, noch bei 4:2:0. Hier die Bilder  http://www.hifi-foru...151&thread=31270&z=7 http://www.hifi-foru...151&thread=31270&z=7Bei RGB 10bit 30Hz siehts übrigens noch schlechter aus, bezüglich Helligkeitswerte und Kontrast... |

||

|

Bow_Wazoo_1

Inventar |

#41

erstellt: 20. Nov 2016, 09:18

|

|

|

Übrigens konnte ich das Color Banding am Himmel, auf Wunsch provozieren in dem ich die HDMI UHD Color Funktion deaktiviert habe. Vielleicht gibts bei deinem TV einen ähnlichen Menüpunkt. |

||

|

Robert_N

Ist häufiger hier |

#42

erstellt: 20. Nov 2016, 11:25

|

|

|

Beim ZD9 heisst das optimiertes Format. Das ist an. Bei mir liegt es daran, dass ich bei 4:2:0 nur 8 Bit wählen kann. Mit 8 Bit gibt es Banding. |

||

|

palmcgee

Stammgast |

#43

erstellt: 20. Nov 2016, 16:03

|

|

"Gamma" im Spiel auf ca. 0.7 stellen. Irgendwie stimmt da was im Rendering des Spiels nicht mMn. Mit 4:2:0 hab ich auch Banding im Himmel. Mein PC packt aber sowieso kein 2160p60, daher hab ich das Problem bei 1080p60 RGB nicht. P.S.: Schon mal bei Nacht in den Himmel geschaut, wenn du in der Hub-Area (vor dem Wang-Cave) stehst?  [Beitrag von palmcgee am 20. Nov 2016, 16:05 bearbeitet] |

||

|

Robert_N

Ist häufiger hier |

#44

erstellt: 20. Nov 2016, 16:07

|

|

|

Ja ich habe das game 2 mal komplett gecleared in 4k@60. |

||

|

Bow_Wazoo_1

Inventar |

#45

erstellt: 20. Nov 2016, 16:30

|

|

|

Gamma verstellen bringt nix. Habs schon probiert... SW2 in HDR hab ich abgehakt |

||

| ||

|

|

||||

| Das könnte Dich auch interessieren: |

|

8 bit zu 10 bit / Unterschied? Garfunkel2002 am 25.10.2009 – Letzte Antwort am 17.11.2009 – 10 Beiträge |

|

10-Bit vs. 8-Bit Panels schups am 21.02.2011 – Letzte Antwort am 22.02.2011 – 9 Beiträge |

|

120 Hz über HDMI jruhe am 17.11.2018 – Letzte Antwort am 19.11.2018 – 6 Beiträge |

|

10-Bit-Panel bei aktuellen Sony-LCDs? audiobot am 23.08.2010 – Letzte Antwort am 16.01.2013 – 18 Beiträge |

|

Sony XD8005 an PC (4K, 60 Hz) markus_v am 19.01.2017 – Letzte Antwort am 20.07.2017 – 4 Beiträge |

|

Sony KD-65XE9305 4K bei 60 Hz pinke "Streifen" pergo777 am 11.09.2018 – Letzte Antwort am 12.09.2018 – 9 Beiträge |

|

kein Ton über HDMI Diddi671 am 02.12.2021 – Letzte Antwort am 03.12.2021 – 8 Beiträge |

|

55XD8505 kein ARC Ton via HDMI 4 ToshiZV635D am 28.02.2017 – Letzte Antwort am 15.03.2017 – 6 Beiträge |

|

MacPro - KDL 46 X 3000: kein 1080p 50Hz/60Hz möglich? Soul71 am 04.09.2009 – Letzte Antwort am 11.09.2009 – 3 Beiträge |

|

Sony KDL W 805c 8 oder 10 Bit Panel /Rübe/ am 19.10.2016 – Letzte Antwort am 19.10.2016 – 2 Beiträge |

Anzeige

Produkte in diesem Thread

Aktuelle Aktion

Top 10 Threads in Sony der letzten 7 Tage

- Sony 55XH9005 ausgeprägte dunkle Ecken

- KDL-75W855C blinkt 6 mal rot

- Sony 2023 MiniLED X95L 65", 75", 85"

- Haben Sony-TV bei Kauf eine Display-Schutzfolie?

- Sony 2017 XE93 55"/65" mit DolbyVision

- KDL-55W805C - LED blinkt 6 mal rot - Totalschaden

- APPs installieren KD-65XF7005

- Sony: Bildeinstellungen erklärt oder "das perfekte Bild"

- XH90 / XH92 Settings Thread

- Netflix-App auf Sony-Bravia gibt IMMER 5.1 aus

Top 10 Threads in Sony der letzten 50 Tage

- Sony 55XH9005 ausgeprägte dunkle Ecken

- KDL-75W855C blinkt 6 mal rot

- Sony 2023 MiniLED X95L 65", 75", 85"

- Haben Sony-TV bei Kauf eine Display-Schutzfolie?

- Sony 2017 XE93 55"/65" mit DolbyVision

- KDL-55W805C - LED blinkt 6 mal rot - Totalschaden

- APPs installieren KD-65XF7005

- Sony: Bildeinstellungen erklärt oder "das perfekte Bild"

- XH90 / XH92 Settings Thread

- Netflix-App auf Sony-Bravia gibt IMMER 5.1 aus

Top 10 Suchanfragen

Forumsstatistik

- Registrierte Mitglieder930.902 ( Heute: 2 )

- Neuestes MitgliedBobibo

- Gesamtzahl an Themen1.564.131

- Gesamtzahl an Beiträgen21.844.155