| HIFI-FORUM » Fernseher & Beamer » Neue Technologien » HDR | |

|

|

||||

HDR+A -A |

||||||

| Autor |

| |||||

|

Falcon

Inventar |

#51

erstellt: 05. Apr 2016, 15:21

|

|||||

Ich will Dir ja nicht komplett widersprechen, weil Du im Prinzip Recht hast. Aber: Effektiv wird dem Nutzer trotzdem die Möglichkeit genommen, das Bild heller zu stellen, wenn ihm die Helligkeit - aus welchen Gründen auch immer - nicht reicht. Das ist ein Stück weit Bevormundung des Nutzers, man sollte ihm wenigstens die Wahl lassen. Eventuell mit einem einfachen Hinweis "Schränkt das HDR Erlebnis ein" oder dergleichen. |

||||||

|

celle

Inventar |

#52

erstellt: 05. Apr 2016, 16:41

|

|||||

|

Wie gesagt, es würde mich nicht wundern, wenn die LG OLED-TVs das bessere HDR-BD-Erlebnis bieten. Im Gegensatz zur Konkurrenz gibt es zusätzlich auch drei verschiedene wählbare HDR-Voreinstellungen u.a. auch einen für Tageslichtschauer. Mit OLED kann man zudem den Nachbarpixel komplett dimmen, während der andere Pixel gleichzeitig hellstes Weiß darstellt. Die Bevormundung muss trotzdem irgendwie sein, weil der Regisseur auch gezieltes Interesse daran hat, sein Machwerk auch am heimischen Screen so zu präsentieren wie er es stilistisch angedacht hatte. Du schreibst ja als Laie dem DaVinci auch nicht vor wie er die Mona Lisa zu malen hat. Aus der Sicht ist die "HDR-Autokalibrierung" eigentlich kein so schlechter Gedanke. [Beitrag von celle am 05. Apr 2016, 16:47 bearbeitet] |

||||||

|

|

||||||

|

V._Sch.

Inventar |

#53

erstellt: 05. Apr 2016, 17:34

|

|||||

Davon schreibe ich schon seit einem Jahr, seit dem Leute hier behaupten, dass das Blendgranaten seien. Die Dunkelheit ist aber schon auffällig und ich erinnere gern an den Versuch von Dolby, als sie Zuschauer nach dem besten Bild befragten und dort unteranderem mit 20 000 Nits arbeiteten. Das Ergebnis wiederhole ich ebenfalls gern, dass Bild mit den 20 000 Nits hat am besten abgeschnitten. |

||||||

|

Falcon

Inventar |

#54

erstellt: 06. Apr 2016, 00:06

|

|||||

Aus "So wie vom Regisseur angedacht" Sicht mag das stimmen. Aber ohnehin wird doch schon jetzt am Bild mit bei den TVs mit Farb-Presets, Zwischenbild-Berechnung und allerlei anderem Schnickschnack fröhlich dran rumgerechnet, genauso wie am Ton. Also wo ist da das Problem dem gewillten Nutzer eine Option zu geben, dass Spektrum der maximalen Helligkeit nach oben hin selbst zu beschneiden!? Theoretisch ist ja jetzt ein Spektrum von 900Nits (100Nits Master und 1000Nits HDR Anforderung) vorhanden. Wenn man da 100 bis 200Nits abzieht (Sprich die Grundhelligkeit entsprechend erhöht), reißt das höchstwahrscheinlich nicht viel raus am HDR Bild, liefert dem Kunden aber dann ein Bild so wie er es will. |

||||||

|

V._Sch.

Inventar |

#55

erstellt: 06. Apr 2016, 03:09

|

|||||

|

Hier mal ein Beamer der HDR richtig kann.  https://www.youtube.com/watch?v=PJzh9BHLLxs&feature=youtu.be https://www.youtube.com/watch?v=PJzh9BHLLxs&feature=youtu.be |

||||||

|

celle

Inventar |

#56

erstellt: 06. Apr 2016, 05:19

|

|||||

Weil es dann kein HDR-Bild mehr ist. Diese wechselnden Tiefen und Spitzen macht HDR ja aus. HDR benötigt feste Regeln, weil es sonst nicht funktioniert.

Man sieht doch beim Digitalfernsehen-Video sehr gut wo das hinausläuft. Dann nehmt SDR-Inhalte und erhöht die Helligkeit, wenn man nur grelle Bilder will. Man beschneidet so aber nur die Tiefen, wenn man das Master selbstständig aufhellt und dann ist der Unterschied zwischen HDR und SDR auf greller Backlighteinstellung kaum noch vorhanden. Bei LCD funktioniert HDR so überhaupt nicht, weil das Backlight zu statisch arbeitet. [Beitrag von celle am 06. Apr 2016, 05:20 bearbeitet] |

||||||

|

von_Braun

Hat sich gelöscht |

#57

erstellt: 06. Apr 2016, 08:14

|

|||||

|

Falcon

Inventar |

#58

erstellt: 06. Apr 2016, 18:23

|

|||||

Das sollte aber bitteschön doch jedem Nutzer selber überlassen sein, und ihm nicht einfach aufgedrückt werden. Es muss auch gar nicht zwingend möglich sein, das Display auf die vollen 1000Nits hochzudrehen, aber ein paar Hundert Nits hin oder her würde m.M.n. keinen großen Unterschied machen, zumal die maximalste Illumination (800-1000Nits) wohl sicherlich eher selten in der Praxis genutzt werden. Und ob man dann noch einen Unterschied zwischen 800 und 1000Nits sieht, ist doch eigentlich wirklich unerheblich. Sch*** grell bleibt es ohnehin  |

||||||

|

V._Sch.

Inventar |

#59

erstellt: 07. Apr 2016, 02:49

|

|||||

|

So wie es aussieht, werden mal wieder alle early birds von den Herstellern abrasiert. Erst dynamische Metadaten werden neue Möglichkeiten bieten, die auf die Möglichkeiten der einzelnen Geräte abgestimmt sind. Dazu benötigt man dann auch noch HDMI 2.1, bei dem noch nicht klar ist, ob das mit jetzigen Geräten möglich ist. Momentan sieht es so aus. dass für jeden Film ein mal statisch die HDR Daten festgelegt werden. Erst zukünftige dynamischen Metadaten werden das ändern. Wer jetzt gekauft hat oder kauft, kauft mit hoher Wahrscheinlichkeit 2 mal. |

||||||

|

celle

Inventar |

#60

erstellt: 07. Apr 2016, 06:07

|

|||||

Spitzen von 700cd/m²+ sind ja trotzdem im Material enthalten, auch wenn der Rest logischerweise eher unter den 100cd/m² liegt. Auch ist kaum ein Unterschied zwischen 500 und 1000cd/m2 wahrnehmbar, genauso wenig wie zwischen 1000 und 10000cd/m². Die Werte blenden so oder so und je stärker, desto dunkler das Umfeld ist. Ich glaube jeder sollte verstehen, wenn die Helligkeit eines Smartphone´s von 500cd/m² bei sonnigen Tageslich ausreicht, man für einen TV in der Wohnung nicht auch wirklich mehr benötigt. Es geht bei HDR nicht um reine Helligkeit - egal welchen Werte die LCD-TV-Hersteller da für ihre Marketingzwecke ausschlachten, sondern um einen erhöhten Dynamikbereich zwischen Hell und Dunkel. Der wird durch bessere Farbunterabtastung, erweiterten Farbraum und bessere Komprimierung zusätzlich erhöht. Der aktuell vorherrschende Nitwahn erinnert schon an den Pixelwahn bei Kameras. Schlimm, das Leute wie bei Digitalfernsehen dies auch noch so fördern, indem sie vollkommen absurde TV-Einstellungen propagieren. Ich kenne in meinem Umfeld keinen einzigen der seinen TV auf höchster Backlightstufe betreibt. Der Regler wird auch bei den normalen Alltags-TV-Schauern im letzten Drittel genutzt. 200-250cd/m² sind für den grellen Tageslichteinsatz vollkommen ausreichend. Ich komme schon mit weit unter 150cd/m² klar. Siehe auch Kemp´s Ausführungen dazu:  https://www.avforums...age-97#post-23448539 https://www.avforums...age-97#post-23448539Oder auch hier:  https://www.avforums...age-97#post-23448604 https://www.avforums...age-97#post-23448604 |

||||||

|

widdl

Stammgast |

#61

erstellt: 07. Apr 2016, 08:36

|

|||||

|

Ich hab ein  sehr interessantes Interview (ab 36:40) gefunden, was auf die Probleme und Lösungsansätze bei HDR und die Vorteile von Dolby Vision eingeht. sehr interessantes Interview (ab 36:40) gefunden, was auf die Probleme und Lösungsansätze bei HDR und die Vorteile von Dolby Vision eingeht.Kurz zusammengefasst: Bei Dolby Vision gibt es eine "Golden Reference List", die ein passendes Remapping der HDR-Metadaten entsprechend der Leistungsdaten des Displays vornimmt. Heißt, das Original wird für 4000 nits gemastert. Bei einem TV mit 1000 nits wird das Bild passend für 1000 nits geremappt, für einen 600/800 nits OLED wird es wiederum anders und passend geremappt, damit es entsprechend gut aussieht. Es sind also dynamische HDR-Metadaten, die passend für unterschiedliche HDR-Displays entsprechend angewendet werden. Es gibt nicht für jeden TV eigene Metadaten, sondern die TVs und Displays werden in Gruppen zusammengefasst (vielleicht bspw. LG OLED Panel 2016 oder FALD 1000 nits). Wenn dem so ist und die Endergebnisse stimmen, finde ich das einen entscheidenden Vorteil von Dolby Vision gegenüber zu HDR10. Noch dazu ist Dolby Vision nicht auf 4K festgestellt. Man kann theoretisch auch einen 720p Stream mit HDR ansehen. Sehr praktisch für's Streaming oder auch für's Gaming. Man arbeitet wohl für HDR10 an einem ähnlichen Verfahren, also dynamische statt statische HDR-Metadaten. Aber bis es soweit ist und ob es dafür neue HDMI-Anschlüsse braucht oder einen Software-Update genügt, steht alles noch in den Sternen. [Beitrag von widdl am 07. Apr 2016, 08:37 bearbeitet] |

||||||

|

von_Braun

Hat sich gelöscht |

#62

erstellt: 07. Apr 2016, 08:46

|

|||||

|

Für Dolby Vision wird HDMI 2.0a völlig ausreichen. Ich gehe davon aus, dass die Gerätehersteller auch Updates dafür herausbringen werden. Viele Grüße |

||||||

|

norbert.s

Hat sich gelöscht |

#63

erstellt: 07. Apr 2016, 09:21

|

|||||

|

Mit den Updates ist das so eine Sache. Wenn man darauf hofft, kommen sie meist nie. ;-) Der Ansatz von Dolby Vision scheint der bessere zu sein. Servus |

||||||

|

norbert.s

Hat sich gelöscht |

#64

erstellt: 07. Apr 2016, 09:25

|

|||||

|

Auch das passt in das Gesamtbild.  http://www.pc-magazi...t-3195249-14924.html http://www.pc-magazi...t-3195249-14924.html...Das Normengremium Society of Motion Picture & Television Engineers (SMPTE) hat für Wieder-gabegeräte eine Gammakurve mit 10 Bits Daten-Codierung standardisiert, ohne einen fixen Helligkeitswert festzuzurren. Es gibt jedoch eine Maximalvorgabe, die sich mit 10.000 Nits an Dolby Vision anlehnt. Diese Norm trägt die Bezeichnung ST-2084. Des Weiteren schreibt die Norm vor, dass die ersten 50 Prozent der Helligkeitsschritte im Bereich zwischen 0 und 100 Nits liegen müssen. 25 Prozent folgen zwischen 100 und 1000 Nits. Die restlichen 25 Prozent warten zwischen 1000 und 10.000 Nits auf... Servus |

||||||

|

von_Braun

Hat sich gelöscht |

#65

erstellt: 07. Apr 2016, 09:48

|

|||||

|

Die Lizenzierung für Dolby Vision beginnt wohl sowieso erst ab Juni 2016.  http://www.hifi-forum.de/viewthread-166-9819-12.html http://www.hifi-forum.de/viewthread-166-9819-12.htmlViele Grüße |

||||||

|

LeDeNi

Inventar |

#66

erstellt: 07. Apr 2016, 09:51

|

|||||

Danke für den Beitrag und die Infos. Kann dir zu 100% zustimmen. Ich habe bei meinen TV das Hintergrundlicht auf minimun und finde es am Abend je nach Film teilweise noch zu grell  |

||||||

|

L37

Stammgast |

#67

erstellt: 07. Apr 2016, 10:07

|

|||||

|

Die Sache bezüglich Dolby Vision klingt sehr gut. Ich fürchte nur, dass die zu spät dran sind, sodass es dafür keinen Content geben wird. |

||||||

|

kalle1111

Inventar |

#68

erstellt: 07. Apr 2016, 10:13

|

|||||

Das ist aus meiner Sicht ein interessanter Ansatz. |

||||||

|

widdl

Stammgast |

#69

erstellt: 07. Apr 2016, 10:20

|

|||||

|

Content gibt es genug, da die meisten Kinofilme mit Dolby Vision gemastert werden. Nun muss das Format "nur" noch ausgeliefert werden mit der UHD-Bluray (da ist es optional) und beim Streaming. Netflix will ja auf Dolby Vision setzen, was angesichts der aktuell verfügbaren DV-kompatible Geräte ein sehr mutiger Schritt wäre. Oder sie bieten beides an, also Dolby Vision und HDR10. Problem bei Dolby ist halt immer, dass es ein proprietärer Standard ist und sie dafür sicher Lizenzgebühren verlangen. Das hat man beim freien HDR10 nicht. Update: Amazon setzt auch auf Dolby Vision, zusammen mit dem bereits verfügbaren HDR10.  Quelle Quelle [Beitrag von widdl am 07. Apr 2016, 10:26 bearbeitet] |

||||||

|

KMario

Ist häufiger hier |

#70

erstellt: 07. Apr 2016, 10:29

|

|||||

|

Dolby Vision ist in USA schon in Einsatz. Hardware: LG OLED G6 oder Vizio P Series Content: Netflix streaming kann mann sich entsprechende threads ansehen beim avsforum:  dolby-vision-showdown-lg-oled-vs-vizio-p-series dolby-vision-showdown-lg-oled-vs-vizio-p-series 2016-lg-oled-65g6p-65e6p-owners-thread 2016-lg-oled-65g6p-65e6p-owners-thread |

||||||

|

L37

Stammgast |

#71

erstellt: 07. Apr 2016, 10:37

|

|||||

|

Okay gut zu wissen. Dann kann die UHD-Bluray ja übernehmen  |

||||||

|

Crash81

Stammgast |

#72

erstellt: 07. Apr 2016, 16:23

|

|||||

Das klingt auf jeden Fall vielversprechend. Ich bin gespannt. Danke dafür  |

||||||

|

Falcon

Inventar |

#73

erstellt: 07. Apr 2016, 22:52

|

|||||

Das ist mir alles klar und ich habe auch nie irgendwas gegenteiliges behauptet. Ich selber nutze den Helligkeitssensor meines TVs und kann mich nicht über die Helligkeit beschweren, geschweige denn dass ich da irgendetwas nachregulieren müsste. Da stört bei Tag eher das Spiegeln des Displays, da mein TV direkt einem Dachfenster gegenüber steht. Es geht mir ausschließlich darum, dass ich es als Unding empfinde, dem Kunden einfach nach dem Motto "Friss oder Stirb" die Entscheidung komplett abzunehmen. Wie Du schon selbst schreibst, ist es ja unerheblich ob ich nun eine theoretische Bandbreite von 900Nits oder von ~700Nits habe. Warum dann nicht dem Kunden erlauben, dass Bild von Anfangs 100Nits als Referenz auf 300Nits anzuheben, wenn er dies denn wünscht!? |

||||||

|

hagge

Inventar |

#74

erstellt: 08. Apr 2016, 06:15

|

|||||

So wie ich es verstehe und so wie man es diesen Quellen entnehmen kann, werden die Daten bei HDR also offensichtlich auf absolute Helligkeiten genormt. Kann mir jemand nochmal schnell erklären, was der Vorteil eines solchen Verfahrens ist, dass es die meiner Meinung nach starken Nachteile so dramatisch überwiegt? Weil das heißt doch im Prinzip, dass der Film mir die Helligkeit vorgibt und ich als Zuschauer letztendlich gar keinen Einfluss mehr auf die Helligkeit nehmen kann/darf. Wenn der Film sagt, da kommen an dieser Stelle nun 500 cd/m², dann kommen die, egal ob ich das bräuchte, egal ob ich gerade im hellen Tageslicht oder im dunklen Kämmerchen schaue. Für mich macht das alles gar keinen Sinn. Ich will doch selbst bestimmen, was ich für Helligkeiten brauche, je nach Situation und je nach persönlicher Vorliebe. Da wäre doch eine relative Reproduktionskurve (wie eben das Gamma momentan) völlig ausreichend. Der absolute Helligkeitswert ist doch auch für die Wahrnehmung eher irrelevant, das ändert sich ja auch ständig, je nachdem wie weit die Pupille des Auges geöffnet ist, also je nachdem wo man vorher hingeschaut hat. Mir ist schon klar, dass man damit eine möglichst realistische Darstellung schaffen will. Aber braucht es das? Weil wenn das konsequent umgesetzt wird, ist der Einwand von Slatibartfass aus  Beitrag #47 gar nicht so abwägig, dass es dann irgendwann mal Schäden am Auge gibt, wenn beispielsweise eine Schweißerszene "realistisch" übertragen wird. Beitrag #47 gar nicht so abwägig, dass es dann irgendwann mal Schäden am Auge gibt, wenn beispielsweise eine Schweißerszene "realistisch" übertragen wird.Gruß, Hagge [Beitrag von hagge am 08. Apr 2016, 06:22 bearbeitet] |

||||||

|

norbert.s

Hat sich gelöscht |

#75

erstellt: 08. Apr 2016, 07:00

|

|||||

|

Der Vorteil liegt klar auf der Hand. Endlich sind alle wichtigen Parameter auf dem Medium klar (zumindest klar genug) festgelegt. Man muss sich bewusst sein, dass dies bisher nicht der Fall war. Einer Blu-ray konnte man nach der Produktion nicht mehr ansehen, wie sie produziert worden ist - man konnte es nur (mit guter Wahrscheinlichkeit) vermuten. Die Flexibilität, die hier zu recht eingefordert wird, muss auf Seiten des Wiedergabegerätes realisiert werden. Nur der Fernseher weiß, was er kann und was nicht und nur der User was er will und was nicht. Diese Flexibilität für den User ist momentan - vermutlich aufgrund der Neue des Features HDR - noch mehr als ungenügend realisiert. Denn beliebige Mappings der Tonwerte in der Form wie man es bisher bei SDR kennt sind problemlos zu realisieren. Der Weg ist auch schon abzusehen, denn beispielsweise die LG OLED mit HDR von 2015 kennen gar keine Flexibilität, die von 2016 bereits drei Presets für unterschiedliche Raumbedingungen/Userwünsche. Und so wird es weitergehen - es wird immer mehr Flexibilität von den Herstellern eingebaut. In ein paar Jahren kräht kein Hahn mehr danach. Der Standard ist neu und jung. Auf beiden Seiten - Medium und Fernseher - läuft noch nicht alles rund. Servus [Beitrag von norbert.s am 08. Apr 2016, 07:02 bearbeitet] |

||||||

|

hagge

Inventar |

#76

erstellt: 08. Apr 2016, 08:08

|

|||||

Dass man eine feste Abbildung vorgibt, ist ja gut. Also nicht heute mit Gamma 2,3, morgen mit Gamma 2,2 und übermorgen mit Gamma 2,4 abmischen. Das war natürlich ungünstig. Aber wenn man hier eine (!) feste Kurve vorgibt, ist doch alles in Ordnung. Es sagt ja niemand, dass das so etwas einfaches wie ein Gamma sein muss. Wenn sich das Sehverhalten des Auges bei sehr dunklen und sehr hellen Stellen eben nicht mehr an eine Gamma-Kurve hält, dann kann man da ja durchaus was Komplizierteres definieren. Und der Fernseher muss sich bei seinen Helligkeiten immer auf dieser Kurve bewegen. Nur welchen Abschnitt der Kurve ich wähle, das will ich mit meinem Helligkeitsregler noch sehr wohl beeinflussen können. Wie dann der Produktionsablauf bei den Firmen intern vor sich geht und ob da alles mit festen Helligkeiten abläuft, kann mir als Endkunde ja egal sein. Das können die gerne so machen.

Aber genau das geht doch anscheinend gerade nicht. Die HDR-BD gibt eine feste Helligkeit vor und die muss ausgegeben werden. Dass es noch drei verschiedene Gruppen gibt (OLED, LCD normal, LCD sehr hell) wird doch auch schon durch drei verschiedene Settings erreicht, die aber schon fix und fertig auf der BD hinterlegt sind. Das heißt der TV wählt sich je nach Typ eines dieser Presets aus, aber ab dann ist alles fest. Meiner Meinung nach kann man da am Endgerät nichts mehr verändern. Und das wäre völliger Quatsch aus meiner Sicht.

Genau, dann haben wir irgendwann stufenlos änderbare Settings mit einem Schieberegler. Und oh Wunder, das verhält sich ja dann wie bisher auch schon jeder Helligkeitsregler. Und dann stellt man auf einmal fest, dass niemand auf der ganzen Welt die HDR-BDs mit den Helligkeiten schaut, für die sie eigentlich gedacht waren. Super, das hat es dann echt gebracht! Wie gesagt, mir will es nicht in den Kopf, was das mit den absoluten Helligkeiten beim Enduser (!) soll. Bisher sieht das für mich so aus, dass es da noch einen ganz gehörigen Denkfehler gibt. Entweder bei mir, oder tatsächlich bei den Erfindern von HDR. Gruß, Hagge |

||||||

|

lordberti

Hat sich gelöscht |

#77

erstellt: 08. Apr 2016, 09:05

|

|||||

|

4K.com hat ein schönen Bericht Veröffentlicht über die Gesamte 4K, HDR und Dolby Vision Problematik  http://4k.com/high-d...t-tvs-content-offer/ http://4k.com/high-d...t-tvs-content-offer/Möchte mal 2 Dinge wegen Dolby Vision Zitieren  : :

|

||||||

|

norbert.s

Hat sich gelöscht |

#78

erstellt: 08. Apr 2016, 09:10

|

|||||

Das ist Dein Denkfehler. Das typische Heimkino wird bisher auf ca. 120 cd/m² für den Weißpunkt kalibriert. Ich mache es nicht anders. Das passt perfekt analog zu HDR auf UHD-Blu-ray, also quasi bis 100 cd/m² hohe Tonwertdichte und darüber quasi den "HDR-Effekt-Kanal". Dass das nicht für jeden passt und dass dies kein Mode für Tageslicht ist und dass eine Flexibilität der Einstellungen für andere Anforderungen dringend erwünscht ist, steht außer Frage. Der Anteil an BD ist am Markt aktuell nur bei um die knapp 40% (und das nach so vielen Jahren!) und der Anteil an UHD-BD wird noch viel geringer sein am Markt und der Anteil an "Hardcore-Heimkino-Fetischisten" ;-) dabei in Relation aber besonders hoch. Servus [Beitrag von norbert.s am 08. Apr 2016, 09:14 bearbeitet] |

||||||

|

KMario

Ist häufiger hier |

#79

erstellt: 08. Apr 2016, 09:25

|

|||||

Du bringst einiges durcheinander ... es gibt keine 3 Presets/Settings/was auch immer auf UHD-BD ... hier  dolby-vision-white-paper-pdf hast du Beschreibung von Dolby was auf HDR-10 UHD-BD drauf ist: dolby-vision-white-paper-pdf hast du Beschreibung von Dolby was auf HDR-10 UHD-BD drauf ist:"Systems with generic HDR carry only static metadata that describes the properties of the color-grading monitor that was used to create the content being played back and some very basic information about the brightness properties (maximum and average light levels) for the entire piece of content."

Um diese Presets geht es: Der LG OLED G6 hat 3 presets für HDR für unterschiedliche Raumbedingungen/Userwünsche: - standard (tja das soll "bat cave" sein) - bright (normale Wohnzimmer) - vivid (helles Wohnzimmer (am tag?)) |

||||||

|

widdl

Stammgast |

#80

erstellt: 08. Apr 2016, 10:09

|

|||||

Woher hast du denn die Info, dass auf der UHD-BR verschiedene Presets für HDR hinterlegt sind? Höre ich gerade zum ersten mal. Ich war der Meinung, dass bislang nur eine Version der HDR-Metadaten vorhanden ist.

Das ist eine ziemlich mutige Aussage, von seinem persönlichen Sehverhalten gleich auf "niemand auf der ganzen Welt" zu schließen  Manche schauen mit den vorgegebenen 100 nits, manche mit 400 nits und wieder andere drehen das Backlight voll auf, was der TV hergibt. Vom HDR abgesehen, profitiert die UHD-BR auch sehr vom Rec. 2020 Farbraum, wo auch noch viel Luft nach oben ist. Momentan beherrschen die TVs erst mal annähernd den DCI-P3-Farbraum und das ist schon ein sichtbarer qualitativer Vorteil im Vergleich zur Bluray mit Rec. 709, selbst mit SDR. [Beitrag von widdl am 08. Apr 2016, 10:12 bearbeitet] |

||||||

|

hagge

Inventar |

#81

erstellt: 08. Apr 2016, 13:37

|

|||||

Es hieß doch früher immer, dass OLED nicht für HDR geeignet ist, weil sie die geforderten hohen Helligkeiten von 1000 cd/m² und mehr nicht hinkriegen. Jetzt heißt es seit 2015, dass es (zumindest) ein weiteres HDR-Grundschema gibt, das dann für die OLEDs geeignet ist und insgesamt auf einem niedrigeren Helligkeitsniveau liegt. Wenn die BD die Daten in absoluten Helligkeiten gespeichert hat, muss sie doch letztendlich (zumindest) zwei Informationen hinterlegen, einmal für die hohen Helligkeiten für LCDs und einmal für die niedrigeren Helligkeiten für OLEDs. Wie soll das sonst gehen, wenn nicht auf der BD? Außerdem stand ja oben das hier:

Das heißt es bekommt eben nicht dynamisch jeder Fernseher ein für ihn geeignetes Remapping, sondern die Geräte werden in Gruppen zusammengefasst. Ich verstehe es so, dass das notwendig ist, weil eben auf der BD dann für jede dieser Gruppen die entsprechenden Daten (bzw. zumindest die Remapping-Daten) mit drauf sind. Und das kann man eben nur für wenige Gruppen machen und nicht für beliebig viele. Warum sollte es sonst diese Beschränkung geben? Gruß, Hagge [Beitrag von hagge am 08. Apr 2016, 13:37 bearbeitet] |

||||||

|

von_Braun

Hat sich gelöscht |

#82

erstellt: 08. Apr 2016, 13:57

|

|||||

|

Warum sollten für OLED Panel nie 1000 cd/m2 oder mehr möglich sein? Wer erzählt solchen Unsinn? Viele Grüße |

||||||

|

lordberti

Hat sich gelöscht |

#83

erstellt: 08. Apr 2016, 13:59

|

|||||

|

Ich glaube ich greife hier mal ein zu Dolby Vision. Erstens ist der Dolby Vision Standard für UHD Blu-Ray noch gar nicht fertig. Nur mal so am Rande. Als nächstes, es soll auf der UHD Blu-Ray Disc der Film in voller Dolby Vision Qualität vorliegen. Der UHD Player mit Dolby Vision Zertifizierung wiederum ließt die Daten aus und gibt diese über HDMI weiter (Also wie gehabt). Nur jetzt kommts. Bei der Übermittlung der Daten werden noch Zusatz Informationen übertragen, die dem TV Helfen bei der Bilddarstellung. Der TV entscheidet selbst wie er das Bild Bestmöglich nach seiner Konfiguration (Hardware) Darstellen kann damit es dem Dolby Vision Standard Entspricht. Es ist entsprechende Hardware verbaut um dies zu ermöglichen. Nits Anzahl usw. Spielen dabei keine Rolle. Gut Zusehen bei Vizio R Serie, die Stammen noch von 2015. Haben nicht mal HDMI 2.0a und nicht mal UHD Premium Siegel. Haben aber Dolby Vision Zertifizierung. Jeder TV der ein Dolby Vision Siegel hat wurde von Dolby selbst in Laboren Zertifiziert. Damit soll halt Gewährleistet werden das die Bestmögliche Qualität der TV im Bezug zu Dolby Vision Darstellen kann. Somit dürfte auch klar sein, das ein normales Firmware update für ein TV nicht ausreicht. Der TV muss entsprechend Hergestellt und durch Dolby Getestet werden. [Beitrag von lordberti am 08. Apr 2016, 14:15 bearbeitet] |

||||||

|

LeDeNi

Inventar |

#84

erstellt: 08. Apr 2016, 15:01

|

|||||

|

widdl

Stammgast |

#85

erstellt: 08. Apr 2016, 15:48

|

|||||

Das sind nur die Anforderungen um das UHD Premium-Logo zu bekommen. Entweder 1000 nits bei einem Schwarzwert von 0.05 nits (das betrifft LCDs) oder 540 nits Spitzenhelligkeit bei einem Schwarzwert von maximal 0,0005 nits (das ist für die OLEDs). Dazu kommt 4K Auflösung, mindestens 90% des DCI-P3-Farbraums und HDR10 als Standard zu verarbeiten. Das sind laut UHD Alliance die Grundvoraussetzungen, um HDR zu ermöglichen. Das ist aber nur das Logo. Auch andere TVs aus 2015 können das, z.B. Samsung JS95090, mit Einschränkungen auch die 2015er LG OLEDs (da fehlt es an den geforderten 540 nits Spitzenhelligkeit), sie können es aber trotzdem wiedergeben.

Was ich oben beschrieben habe mit den dynamischen HDR-Daten und der "Golden Reference List", bezieht sich nur auf Dolby Vision, nicht auf HDR10 oder HDR im allgemeinen. Aktuell gibt es noch keine UHD-BR mit optionalem Dolby Vision, die haben alle nur HDR10. Das Remapping auf die niedrigere Helligkeit bei der Wiedergabe macht der TV, nicht die Disc oder der Player. Das heißt er verlässt zwangsläufig die Masteringvorlage. Würde er das aber nicht machen, würden alle Helligkeitsstufen über der erreichbaren Spitzenhelligkeit abgeschnitten und helle Details würden damit ausbrennen. Meines Wissen sollen die 2015er OLEDs kein Remapping durchführen, sondern nur die 2016er. Es bleibt also spannend wie die Probleme gelöst werden. Ist gerade eine heiße und interessante Phase. Noch ist es nicht perfekt, aber ich denke es wird und wir sind auf einem guten Weg. Momentan finde ich den Ansatz von Dolby Vision wesentlich flexibler und praktikabler als die anscheinend sehr starre HDR10-Umsetzung. Da bei mir ein 2016er LG OLED geplant ist (der Dolby Vision zertifiziert ist), hoffe ich das sich Dolby zunehmend verbreitet, da es in meinen Augen momentan bessere HDR-Ergebnisse liefert als HDR10. [Beitrag von widdl am 08. Apr 2016, 15:53 bearbeitet] |

||||||

|

hagge

Inventar |

#86

erstellt: 08. Apr 2016, 15:49

|

|||||

Niemand erzählt das. Das hast Du missverstanden. Es ging um die aktuellen Geräte momentan. Die Hersteller wollen JETZT eine HDR-Zertifizierung, aber da ursprünglich eigentlich mehr als 1000 cd/m² gefordert waren, wäre es momentan (!) mit OLED nicht möglich gewesen. Und darum wurde nachträglich eine zweite Kategorie für HDR definiert, die dann besser mit OLED harmoniert. Dank LeDeNi und seinem Link kann ich das jetzt sogar genau beziffern: Beim Label "Ultra HD Premium" gibt es die Kategorie 1, wo ein Display einen Helligkeitspeak von mehr als 1.000 Nits haben muss und weniger also 0,05 Nits Schwarzpegel (-> LCD). Und bei Kategorie 2 muss das Display mehr als 540 Nits Maximalhelligkeit und weniger als 0,0005 Nits Schwarzpegel haben (-> OLED). [EDIT: Da ist mir doch glatt widdl dazwischen gerutscht und hat die Werte auch schon genannt.] So und jetzt kommt meine Frage: wenn die Daten in absoluten Werten übertragen werden, wie will die BD dann wissen, dass sie auf einem Gerät für Kategorie 1 oder Kategorie 2 läuft? Das geht doch nur, wenn sie irgendwie Daten für beide Kategorien erzeugen kann.

Bist Du Dir mit dem letzten Satz da wirklich sicher? Weil genau das stimmt meiner Meinung nach nicht. Sonst müsste man ja nicht solche Definitionen machen, dass der TV "mindestens" 1000 Nits haben muss, wenn doch jeder seine Kiste entsprechend dunkler einstellen kann, so dass es die 1000 Nits sowieso nie erfordert, und er dann auch HDR anzeigen kann. Außerdem schreibt norbert.s ja (zugegeben über eine andere Norm):

Das heißt es findet sehr wohl eine Zuordnung von Helligkeitstufen (also den 10- oder 12-bit-Werten) zu absoluten Helligkeiten (Nits) statt. Gruß, Hagge [Beitrag von hagge am 08. Apr 2016, 15:58 bearbeitet] |

||||||

|

norbert.s

Hat sich gelöscht |

#87

erstellt: 08. Apr 2016, 16:26

|

|||||

|

Das Master für HDR10 wird für 1000 Nits und bei Dolby Vision (aktuell) für 4000 Nits erstellt. Die jeweiligen Fernseher wissen selbst was sie können (LG OLED 2016 eben "nur" ca. 600 bis 700 Nits) und wenden ein passendes Mapping der Töne an. Daher muss der UHD-BD-Player nichts über den Fernseher wissen. Der Player schickt einfach seine Daten und Meta-Daten an den Fernseher und der Fernseher interpretiert sie nach seinen Fähigkeiten. Servus [Beitrag von norbert.s am 08. Apr 2016, 16:29 bearbeitet] |

||||||

|

widdl

Stammgast |

#88

erstellt: 08. Apr 2016, 16:47

|

|||||

|

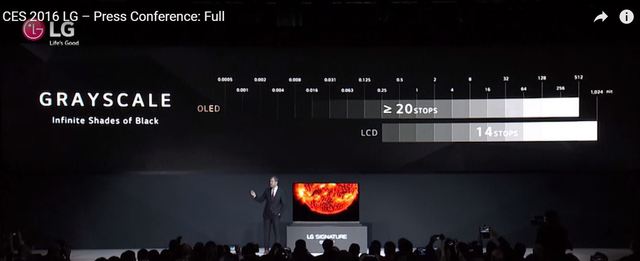

@hagge Das UHD Premium Logo schreibt nur für die TVs die Hardware-Anforderungen vor, um (ihrer Meinung nach) ein gutes HDR-Erlebnis zu haben. Über Sinn und Umsetzung lasse ich mich jetzt mal nicht weiter aus. Nur kurz soviel: Es wäre noch Spielraum nach oben gewesen, aber sei es drum. Für Vertrieb und Mastering gelten nur folgende Vorgaben: Auflösung: 3840×2160 Farbtiefe: Minimum 10-bit Signal Farbraum: BT.2020 Farbwiedergabe High Dynamic Range: SMPTE ST2084 EOTF =HDR10  Quelle QuelleFür die gelten also keine festen Helligkeitswerte. Der Grund weshalb man sagt, dass 50% bis 100 nits, 25% bis 1000 nits usw liegt daran, dass das menschliche Auge Helligkeitsunterschiede im dunklen wesentlich besser differenzieren kann als im hellen. Hier mal eine Erklärung von LG dazu ...  Wie wissenschaftlich fundiert das ist, kann ich allerdings nicht sagen. Allerdings kann man an dem Bild schön sehen, was Clipping bedeutet: Ich sehe ab der 128 nits Markierung nur noch einheitlich weiß und keine Abgrenzung mehr (am Notebook-Display). Das kann aber auch an der mittelmäßigen YouTube-Qualität liegen, was auch nur ein Stream-Mitschnitt ist. Und genau um solches Clipping zu vermeiden, wird ein Remap durchgeführt bei den 2016er LG OLEDs, damit alle Abstufungen sichtbar bleiben. [Beitrag von widdl am 08. Apr 2016, 16:53 bearbeitet] |

||||||

|

norbert.s

Hat sich gelöscht |

#89

erstellt: 08. Apr 2016, 17:03

|

|||||

Nein und Ja. :-) Wenn ich 10-bit mit 1024 Graustufen habe und 50% der Stufen sollen zwischen 0 und 100 Nits liegen, dann ordnet man schon irgendwie Tonwerten nahezu absolute Leuchtdichten zu. Dazu im zitierten Link weiter oben von mir: ...Zwei wichtige Hürden für eine Vereinheitlichung wurden bereits genommen. Das Normengremium Society of Motion Picture & Television Engineers (SMPTE) hat für Wieder-gabegeräte eine Gammakurve mit 10 Bits Daten-Codierung standardisiert, ohne einen fixen Helligkeitswert festzuzurren. Es gibt jedoch eine Maximalvorgabe, die sich mit 10.000 Nits an Dolby Vision anlehnt. Diese Norm trägt die Bezeichnung ST-2084. Des Weiteren schreibt die Norm vor, dass die ersten 50 Prozent der Helligkeitsschritte im Bereich zwischen 0 und 100 Nits liegen müssen. 25 Prozent folgen zwischen 100 und 1000 Nits. Die restlichen 25 Prozent warten zwischen 1000 und 10.000 Nits auf... Und von SpectraCal: ...HDR10 content has meta data content describing the mastering monitor peak brightness and native gamut. How that get maps down to the target device is undefined and up to each manufacturer to implement. This is where Dolby Vision is widly more thought out... Servus [Beitrag von norbert.s am 08. Apr 2016, 17:06 bearbeitet] |

||||||

|

widdl

Stammgast |

#90

erstellt: 08. Apr 2016, 17:15

|

|||||

|

Ja, je länger man drüber nachdenkt und sich damit beschäftigt, desto absurder wird es eigentlich  Hier wird keine Helligkeit festgelegt, 2 Sätze weiter wird es aber so eng definiert, das es faktisch einer Helligkeitsfestlegung entspricht, und wie und in welcher Helligkeit das ganze dann am TV dargestellt wird, wird den Herstellern überlassen. Schon irgendwie abstrus. Mir wird Dolby Vision immer sympathischer  [Beitrag von widdl am 08. Apr 2016, 17:17 bearbeitet] |

||||||

|

hagge

Inventar |

#91

erstellt: 08. Apr 2016, 17:24

|

|||||

Schon klar. Deshalb hat man ja auch schon bisher eine Gamma-Kurve genommen. Das Auge hat ein Gamma von irgendwo um die 2,4 rum. Aber die obige Verteilung (50/25/25%) würde auf ein Gamma von über 7 hindeuten, ja fast 8. Das wäre schon stark abweichend vom Gamma des Auges. Also kann das dort keine reine Gamma-Kurve mehr sein, die sich nur an der Empfindlichkeit des Auges orientiert. Mir geht es bei der ganzen Diskussion nur um eines, dass ich es irgendwie blöd fände, wenn auf so einer HDR-BD irgendwie absolute Helligkeitswerte drauf wären. Aber es scheint ja irgendwie doch so zu sein. Und darum habe ich heute morgen gefragt, was das für Vorteile hat. Aber anscheinend weiß hier letztendlich auch niemand sicher, ob das nun absolute Werte auf der BD sind oder nicht. Du sagst nein. Wäre mir recht. Was man so liest klingt aber bisweilen anders. Gruß, Hagge |

||||||

|

Falcon

Inventar |

#92

erstellt: 08. Apr 2016, 17:36

|

|||||

|

Es ergibt durchaus Sinn, die Signalquelle möglichst starr zu definieren. Wie dann der TV oder Projektor mit dem Signal verfährt, ist doch eine ganze andere Frage. Man kann nur hoffen, dass die Hersteller hier im Sinne der Nutzer (Mehr Optionen sind immer besser als weniger!) nachbessern. |

||||||

|

norbert.s

Hat sich gelöscht |

#93

erstellt: 09. Apr 2016, 06:42

|

|||||

|

Im Prinzip sehe ich bei HDR10 die Leuchtdichten und Zuordnung zu Tonwerten (siehe Beiträge und Zitate weiter oben) tatsächlich für relativ fix auf dem Medium (Zitat von SpectraCal: HDR10 content has meta data content describing the mastering monitor). Trotzdem kann beim Mastering auch wieder relativ frei entschieden werden, wie hell der Film abgestimmt wird und damit welche Tonwerte benutzt werden. Die Interpretation der Daten und Meta-Daten obliegt dem Fernseher. Dynamische Meta-Daten wie bei Dolby Vision erleichtern ihm dabei die Arbeit. Er kann es 1:1 interpretieren oder eben seinen Fähigkeiten angepasst. Und hoffentlich zukünftig auch den Wünschen des Besitzers angepasst. Servus [Beitrag von norbert.s am 09. Apr 2016, 06:46 bearbeitet] |

||||||

|

Supermario

Inventar |

#94

erstellt: 09. Apr 2016, 07:22

|

|||||

|

Das war doch früher nicht anders. Zu SD(R) Zeiten mit CRT-TV's und CRT Mastering Monitoren war die Norm 100 Nits. Später wurde das auch im bt.709 Standard, sRGB Standard und evtl. noch anderen niedergeschrieben. Die Hersteller haben aber zunächst aus Mangel einer strikten Vorgabe durch einen Standard bzw. Gütesiegel ihre TV's heller gemacht wie es sein sollte um die Konkurrenz auszustechen. Die Formeln für bt.709, sRGB usw. beziehen sich bei der Gammakurve bzw. EOTF und auch OETF auf meistens 100 Nit bei Weiß und 0,0 bis 0,5 Nit bei Schwarz. Heute zu HD(R) Zeiten haben wir gleich einen fest definierten Standard und eine Gütesiegel und die Hersteller halten sich erstmal daran. Wird aber hoffentlich nicht lange dauern bis der User da mehr eingreifen kann. |

||||||

|

norbert.s

Hat sich gelöscht |

#95

erstellt: 09. Apr 2016, 08:41

|

|||||

|

Jein. Die 100 Nits kommt von den CRTs, die nicht mehr (ohne ABL) konnten. Dann hat man viele Jahre nichts angepasst, obwohl die (End-)Geräte immer mehr konnten. Was aber auch daran lag, dass die LCDs lange Jahre für das Erstellen von Master nicht geeignet waren. Beim Gamma ist man auch munter zwischen 2.2 und 2.4 (Power Formula) hin- und hergesprungen. Heute mit der UHD-BD hat man sich getraut einen Standard zu nutzen (UHD-1 Phase 2), der mehr kann, als die (End-)Geräte der nächsten zwei oder drei Jahre. Ich persönlich begrüße das. Der Standard ist so neu und jung, dass es eben an diversen Ecken knarzt und knirscht. Servus |

||||||

|

norbert.s

Hat sich gelöscht |

#96

erstellt: 09. Apr 2016, 08:53

|

|||||

http://www.displayda...itor-evaluation-need http://www.displayda...itor-evaluation-need...The PQ curve not only covers a much large range of luminance values, but the code values are locked to certain luminance values. That means a pixel that is supposed to be at 100 nits will have a specific code value. That is not the case with the other gamma curves where the code values can have different luminances depending upon the range of the particular display... ...HDR 10 is mastered to a set of luminance ranges (0.01 to 400 nits) and includes only static metadata, which applies to the entire piece of content, not scene by scene. It lacks the sophisticated luminance mapping in Dolby Vision and is more likely to simply clip content that is out of the luminance range of the TV... 400 Nits? Ich dachte, es wären 1000 Nits beim Mastering. Aber vermutlich fehlen wieder die passenden Monitore für das Mastering. ;-) Servus [Beitrag von norbert.s am 09. Apr 2016, 08:54 bearbeitet] |

||||||

|

widdl

Stammgast |

#97

erstellt: 09. Apr 2016, 09:07

|

|||||

|

Das würde auch erklären, warum die Bilder so extrem dunkel sind, wenn 400 nits schon das Maximum an Helligkeit bei HDR10 wären. Andererseits hat das HDTV-Magazin in ihrem YT-Video bei Mad Max stellenweise 600 nits bei der Sonne in Mad Max gemessen. |

||||||

|

norbert.s

Hat sich gelöscht |

#98

erstellt: 09. Apr 2016, 09:35

|

|||||

|

Ich gehe davon aus, dass die 400 eine fehlerhafte oder fehlinterpretierte Angabe sind. Alles was ich bisher darüber lesen konnte sprach von 1000 für HDR10 beim Mastering. Aber eventuell fehlen eben noch die passenden Monitore für das Mastering. ;-) Servus |

||||||

|

Supermario

Inventar |

#99

erstellt: 09. Apr 2016, 12:37

|

|||||

|

Bei Dolby Vision sind die Mastering Monitore bei 4000 Nits. Bei HDR 10 soll es eigentlich auch so sein. Da wird also nur eine 0 gefehlt haben bei den 400 Nits.

Das steht zwar irgendwo, sollte aber falsch sein. Nach der Präsentation des Teams was die PQ-EOTF (SMPTE 2084) entwickelt hat, kann die Formel für verschiedene Helligkeiten angewandt werden, genauso wie früher ein Power-Law Gammakurve. Der Vorteil ist, das auch auf z.B. 400 Nits angewendet man eine Super Schattendurchzeichnung hat und kein Banding (Posterization). Außerdem steckt keine Helligkeitsinformation in den Videostromdaten, nur in den Metadaten. Was noch alles in den Metadaten steht wissen wir noch gar nicht. Also wie werden 2 Versionen (SDR und HDR) eines Films genau erstellt beim Mastering und wie werden sie auf der UHD-BD abgelegt. [Beitrag von Supermario am 09. Apr 2016, 12:39 bearbeitet] |

||||||

|

Aragon70

Inventar |

#100

erstellt: 10. Apr 2016, 01:30

|

|||||

|

Habe mir auch mal das HDTV Video angesehen und bin nun doch ernüchtert. Da predigen sie einem in allen möglichen Zeitschriften über Monate hinweg das HDR eine große Verbesserung der Spitzenhelligkeit bringt, aber die Filme werden alle dunkler, das passt nicht zusammen. Scheint so zu sein das sich die Helligkeit des Films nach der "hellsten" Stelle richtet und der Rest soweit abgedunkelt wird daß das "richtig" in Relation dazu steht, damit wäre das dunkle Bild logisch. Aber eigentlich ist das doch auch Quatsch, das menschliche Auge passt sich ja an unterschiedliche helle Umgebungen an, geht man von einem hellen in einen dunklen Raum so wird man erstmal nichts sehen können, aber nach einigen Sekunden stellen sich die Augen darauf ein und man sieht wieder deutlich mehr. Geht man wieder zurück ins Hell wird man erstmal geblendet, aber das normalisiert sich wieder und man sieht wieder "normal". Mir scheint HDR ist ein Feature nachdem keiner in der Form gefragt hat und es löst ein Problem das für die meisten nie existiert hat. |

||||||

|

Siebert78

Hat sich gelöscht |

#101

erstellt: 10. Apr 2016, 08:51

|

|||||

|

Wenn das, was die im Video erklären, wirklich stimmt, dann wird die UHD samt HDR wohl ein riesen Flop. Zuerst sterben die Plasma TVs aus, weil sie angeblich so dunkel sind und jetzt wird wieder ein Schritt in diese Richtung gemacht (dunkles Bild etc). Mag sein, das das alles "original-like" ist, aber das hat ja bei den Plasmas schon nicht gezogen auf Dauer bei der Maße (der Plasma hatte und hat immer noch das "echteste" Kinobild überhaupt). |

||||||

| ||||||

|

|

||||

| Das könnte Dich auch interessieren: |

|

HDR 10+, Dolby Vision PeterHimmel am 20.08.2020 – Letzte Antwort am 01.12.2022 – 18 Beiträge |

|

WIedergabe einer HDR Demo assuz am 06.12.2015 – Letzte Antwort am 08.12.2016 – 13 Beiträge |

|

Playstation Pro unterstützt HDR nicht Blumenring am 10.11.2016 – Letzte Antwort am 10.11.2016 – 4 Beiträge |

|

Hdr zu dunkel ? krashkrash am 05.03.2017 – Letzte Antwort am 12.06.2017 – 4 Beiträge |

|

Frage zu HDR10, DolbyVision und HDR Plus Deckard2019 am 08.10.2017 – Letzte Antwort am 09.11.2017 – 11 Beiträge |

|

Digitalfotos auf HDR-TV besserer? stefan516 am 14.12.2021 – Letzte Antwort am 18.12.2021 – 10 Beiträge |

|

HDR Unterstützung ohne Dimming joeM5 am 11.08.2017 – Letzte Antwort am 14.08.2017 – 4 Beiträge |

|

Hilfe bei YT Video mit HDR Blumfeld1 am 22.12.2021 – Letzte Antwort am 23.12.2021 – 5 Beiträge |

|

Unterschiedliche HDR-HLG TV Channels dinandus am 10.03.2018 – Letzte Antwort am 17.12.2019 – 16 Beiträge |

|

Verständnisfragen: LG Active HDR - HDR HLG -Dolby Vision htpc4ever am 18.11.2017 – Letzte Antwort am 06.03.2018 – 12 Beiträge |

Anzeige

Produkte in diesem Thread

Aktuelle Aktion

Top 10 Threads in Neue Technologien der letzten 7 Tage

- Govee WLAN TV | /Ambilight) Beleuchtung Kit mit Kamera

- Philips Hue Sync Box - potentielle Lösung für Probleme bei der Lichtsynchronisation

- Unterschied HDR10+ und HDR10 Pro

- Der allgemeine Heim-3D-Thread

- Govee Geräte mit zwei Handy´s steuern ?

- Verständnisfragen: LG Active HDR - HDR HLG -Dolby Vision

- Farbtiefe; Deep Color und 12bit

- Amazon Prime Video auf Panasonic TV

- Am Beamer besser 3D H-SBS oder H-OU ?

- Unterschied Dolby Vision und Dynamisches HDR (HDMI2.1)?

Top 10 Threads in Neue Technologien der letzten 50 Tage

- Govee WLAN TV | /Ambilight) Beleuchtung Kit mit Kamera

- Philips Hue Sync Box - potentielle Lösung für Probleme bei der Lichtsynchronisation

- Unterschied HDR10+ und HDR10 Pro

- Der allgemeine Heim-3D-Thread

- Govee Geräte mit zwei Handy´s steuern ?

- Verständnisfragen: LG Active HDR - HDR HLG -Dolby Vision

- Farbtiefe; Deep Color und 12bit

- Amazon Prime Video auf Panasonic TV

- Am Beamer besser 3D H-SBS oder H-OU ?

- Unterschied Dolby Vision und Dynamisches HDR (HDMI2.1)?

Top 10 Suchanfragen

Forumsstatistik

- Registrierte Mitglieder930.768 ( Heute: 7 )

- Neuestes MitgliedNeedadvice09

- Gesamtzahl an Themen1.563.776

- Gesamtzahl an Beiträgen21.835.163