| HIFI-FORUM » Fernseher & Beamer » Neue Technologien » Alles zum Thema Dolby Vision | |

|

|

||||

Alles zum Thema Dolby Vision+A -A |

||||||

| Autor |

| |||||

|

RCZ

Inventar |

#151

erstellt: 05. Aug 2017, 09:07

|

|||||

|

Super, danke für das Video. Es ist unglaublich wie kompliziert es ist, HDR zu Hause richtig einzustellen, zumal man eben nicht weiß auf was die UHD Disc gemastert ist und die Meisten nur in HDR10 erschienen sind. Dolby Vision scheint recht gut zu funktionieren, dass setzt aber wieder den richtigen TV, also nur LG und Player voraus (Oppo). Alles andere ist, zumndest Stand heute, meiner Meinung nach eine Katastrophe. |

||||||

|

meistro.b

Inventar |

#152

erstellt: 05. Aug 2017, 10:22

|

|||||

|

Du hast SONY vergessen  Die TVs bekommen ein Update für Dolby Vision |

||||||

|

|

||||||

|

willwaswissen

Inventar |

#153

erstellt: 05. Aug 2017, 11:01

|

|||||

|

Ja, das Video bestätigt auch mein Chaos beim mühsamen Herausfinden der besten HDR-Bildeinstellungen. |

||||||

|

HicksandHudson

Inventar |

#154

erstellt: 05. Aug 2017, 11:42

|

|||||

|

Aber ganz ehrlich. ....das kann doch nicht sein, dass ich bei jedem Film rumstellen muss?  Ist doch eh schon aufwendig genug, den TV überhaupt sauber hinzukriegen von den Einstellungen her. |

||||||

|

rockopa

Hat sich gelöscht |

#155

erstellt: 05. Aug 2017, 14:13

|

|||||

|

Ich habe nur eine Einstellung wenn ich Filme mit HDR anschaue. Ich als Laie kann da sowieso keinen Unterschied feststellen wenn ich bei jedem Film was anderes einstellen muss. Dazu fehlt mir einfach das Fachwissen. |

||||||

|

HicksandHudson

Inventar |

#156

erstellt: 05. Aug 2017, 14:22

|

|||||

|

Danke. Das gibt mir Hoffnung  |

||||||

|

langsaam1

Inventar |

#157

erstellt: 05. Aug 2017, 15:14

|

|||||

|

offtopic (ein wenig) da hier DV das Thema ist ... HDR und die Anderen Varaiationen ist keine !!!! " wie find ich persönlich das mir passende Bild " !!! Sondern - Soll SO gesehen werden Wie ist Vorliegt !!! Bemängel ich schon von Anfang der Diskussion: Die beteiligten Geräte MÜSSEN sich bei "Erkennen" der jeweiligen Kennung (HDR DV HLG etc.) in einen Festen, vom Nutzer NICHT veränderbaren Modus schalten. (Samsung hatte zumindest dies als Option in den ersten HDR fähigen TV Geräten, war dem Nutzer aber zu umständlich und er begriff es nicht. Wer fummelt auch in 3 Untermenüs VOR und NACH der HDR Zuspielung herum .. um den Modus jeweils zu Aktivieren und zu deaktivieren ... geschweige denn das dem Nutzer überhaupt diese Option / Funktion bewusst ist.) - Panaosnic bietet eine ähnliche Option in den hochpreis Modelle auch an > festen HDR Modus - für DV fehlt so ein Modus noch, bei LG kann man trotz DV Mode noch an Einstellunegn "herumfummeln" [Beitrag von langsaam1 am 05. Aug 2017, 15:20 bearbeitet] |

||||||

|

michael4

Stammgast |

#158

erstellt: 05. Aug 2017, 20:18

|

|||||

|

Sehe ich nicht so, zumindest nicht wenn es nicht noch ein Art Expertenmodus oder so gäbe. Wenn alle TV einer Serie 100% gleich wären, ok. Aber da es hier zig Unterschiede gibt (verschiedene Panelhersteller, Revisionen usw.), wäre das nichts für mich. Schön wäre, wenn man 1x kalibriert, sprich Weißabgleich usw., und sich die Bildmodi dann adaptiv darauf anpassen würden. |

||||||

|

George_Lucas

Inventar |

#159

erstellt: 06. Aug 2017, 21:06

|

|||||

Das sehe ich in Bezug auf HDR anders, weil viele Wiedergabegeräte die erforderliche Leuchtdichte nicht erfüllen, der Nutzer bei Tag HDR als zu dunkel empfinden kann, und die max. Leuchtdichte (z. B. 1000 Nits) vom Kontent oftmals nicht ausgeschöpft wird. Hier empfinde ich individuelle Anpassungen so lange sinnvoll, bis zumindest die Wiedergabegeräte die erforderliche Leuchtdichte besitzen. |

||||||

|

RCZ

Inventar |

#160

erstellt: 07. Aug 2017, 05:18

|

|||||

|

Das Problem liegt doch eher darin, dass die Filme sehr dunkel gemastert werden, dass wird auch im Video erklärt. Selbst wenn dein TV 10.000 nits schaffen könnte, die Hälfte des Films aber mit max. 80-120nits gemastert ist, dann siehst du halt in eben diesen Szenen max. 80-120nits. Lediglich einzelne (kleine) Bildbereiche haben z.b. 3000nits. Dennoch ist das Bild im Ganzen recht dunkel, was in einem hellen Raum tagsüber zu wenig ist. Und genau das wird dem otto-normal-gucker nicht gefallen und er möchte gegenregeln. Das ist er ja bisher auch so gewohnt.  |

||||||

|

Chris3636

Inventar |

#161

erstellt: 07. Aug 2017, 14:15

|

|||||

|

Ich bin ja gespannt , ob Hdr10+ ein uhd blu Ray standard wird. Und nicht nur bei Amazon vorgesehen ist. So wie Es Im Moment aussieht wird Dolby Vision das Rennes machen. |

||||||

|

Henro

Stammgast |

#162

erstellt: 07. Aug 2017, 14:28

|

|||||

|

naja mit bisher 2 UHDs ist der Vorsprung nicht besonders groß. Die ganzen großspurigen Ankündigungen nehme ich auch nicht mehr so ernst, seitdem Disney bei GoG2 einfach mal zurück gerudert ist. |

||||||

|

rockopa

Hat sich gelöscht |

#163

erstellt: 07. Aug 2017, 14:34

|

|||||

|

Das glaube ich momentan nicht das Dolby Vision das Rennen macht. |

||||||

|

Chris3636

Inventar |

#164

erstellt: 07. Aug 2017, 15:32

|

|||||

|

Wenn hdr10+ Es auf die ultra blu ray schafft und die großen studios Mit ziehen dann wird Es spannend, aber so Lang das nicht geschieht. + Punkt für Dolby. Mir ist es endeffekt egal. Nach der ifa sind wir Glaub ich schlauer. |

||||||

|

HicksandHudson

Inventar |

#165

erstellt: 07. Aug 2017, 16:31

|

|||||

|

Ganz ehrlich... eigentlich sollten wir aktuell alle gar keinen HDR-TV kaufen oder das Format irgendwie nutzen.....solange bis Klarheit herrscht  |

||||||

|

berti86

Hat sich gelöscht |

#166

erstellt: 07. Aug 2017, 16:43

|

|||||

Ich Glaube schon.  Bei den Hollywood Studios ist nur noch 20th Century Fox das einzige Hollywood Studio was sich noch gegen Dolby Vision stellt. Alle anderen haben sich bereits für Dolby Vision entschieden. Disney gab am Wochenende bei einem Presse-Event bekannt, in Zukunft bei UHD Blu-Ray auch auf Dolby Vision zu setzten. So sieht es jetzt seit dem Wochenende Offiziell aus mit Dolby Vision in Zukunft: Dolby Vision im Streaming: Warner Bros MGM Universal Pictures Sony Pictures Paramount Pictures Walt Disney Dolby Vision bei UHD Blu-Ray: Warner Bros Universal Pictures Sony Pictures Paramount Pictures Walt Disney Lionsgate [Beitrag von berti86 am 07. Aug 2017, 16:44 bearbeitet] |

||||||

|

TheSoundAuthority

Inventar |

#167

erstellt: 07. Aug 2017, 16:44

|

|||||

Es gibt keine finale Software, um die Master für UHDs zu erstellen - daher gibt es noch keine Filme. Diese befindet sich aber derzeit in der Finalisierung.

Wenn du danach gehst, darfst du nie kaufen... "HD Ready" - "Full HD" - "Full HD 3D" - "Ultra HD" - "Ultra HD Premium" - "HDR10" - "HDR+" - "Dolby Vision" .... |

||||||

|

Chris3636

Inventar |

#168

erstellt: 07. Aug 2017, 16:58

|

|||||

Ich wollte eigentlich zu schlagen, aber ich halt mich bis jetzt erfolgreich zurück... Ich will keine dunklen.bilder haben. Das war ein Grund warum ich mit dem kalibrieren angefangen hab, um alles details zu sehen. Finde das gerade bei dunklen bilder spannend was man alles sehen kann. |

||||||

|

Klipsch-RF7II

Inventar |

#169

erstellt: 07. Aug 2017, 17:02

|

|||||

|

Warum erzählen denn die TV Besitzer so viel von dunklen Bildern? Sind die Presets da wirklich so schlecht? Kann man denn garnichts an der Gamma Kurve drehen? |

||||||

|

berti86

Hat sich gelöscht |

#170

erstellt: 14. Aug 2017, 21:07

|

|||||

|

Transformers: The Last Knight wird Paramounts erster UHD Blu-ray Release in Dolby Vision  http://www.blu-ray.com/news/?id=21883 http://www.blu-ray.com/news/?id=21883 |

||||||

|

langsaam1

Inventar |

#171

erstellt: 14. Aug 2017, 22:54

|

|||||

|

offtopic: siehe Post 159 HDR Spec diesen ominösen 1000 Nits TV hatten Anfangs um 350-400 Nits die aktuelle ToppModelle und nur die liegen aktuell um die 600-700 Nits Theorie. - das Film HDR kann man nicht direkt mit Photo Bild HDR vergleichen, aber um die "Lichtdifferenz" herauszuholen, je dunkler Film und Umgebung, je "idealer" kommt die Differenz heraus. Da aber im Grossenteil unbekannt ist mit welchem Nits Wert die HDR Kontent erstellt bzw. dann gesendet wird ist kaum nachvollziehbar. Bespiel der Anbieter mastert tatsächlich mit diesen 1000 Nits ... und der TV kann davon gerade einmal 400 "umsetzten" > es wirkt zu dunkel UND es ist eben nicht so wie es vom Anbieter / Produzen bei Betrachtung angedacht bzw. gewünscht währ. Inwieweit sich dies bei DV auswirkt muss man noch beobachten. |

||||||

|

hagge

Inventar |

#172

erstellt: 15. Aug 2017, 05:45

|

|||||

Das Problem entsteht genau dann, wenn ein TV die vom Film per Metadaten geforderten Helligkeiten nicht erfüllen kann. Dann gibt es aber nicht nur bei HDR10 Probleme, auch die Verfahren mit dynamischen Metadaten, also Dolby Vision oder HDR10+, können nicht alle Probleme beseitigen. Ich habe das gestern mal im Thread "OLED gegen LCD" erklärt und kann es gerne auch hier nochmal kurz ausführen. Die Frage ist, welche Helligkeit eine HDR-Scheibe fordert. Und da kann es Probleme geben. Ist doch logisch. Die HDR10-Scheibe sagt: "Ich würde gerne bis zu 1000 cd/m² Helligkeit haben." Ein heller LCD-TV wie der ZD9 von Sony sagt: "Alles klar, kein Problem" und dann zeigt er alles 1:1 so an, wie die HDR10-Scheibe das will. Ergebnis: perfekte Darstellung. Ein TV wie ein OLED muss aber sagen: "Hups, 1000 cd/m² kann ich nicht, ich kann nur 500 cd/m²". Und jetzt muss er eben anfangen, Kompromisse einzugehen, sprich ein Tonemapping-Verfahren einzusetzen.

Wie man sieht ist das Ergebnis sehr oft ein zu dunkles Bild über große Strecken des Films. Es stellt sich also die Frage: Ist wirklich der Film so dunkel gemastert, oder wird er nur so dunkel angezeigt, weil der TV einen Kompromiss bei der Anzeige machen muss? Ich Wohlgemerkt, das ist nicht per se ein Problem von OLED. Auch ein LCD wie der ZD9 kommt in genau die gleiche Breduille, wenn er einen Film anzeigen soll, der über die 1800 cd/m² hinaus geht, die er maximal kann. Aber bei ihm passiert das eben nur bei Filmen, die für mehr als 1800 cd/m² gemastert sind, alle Filme, die darunter liegen, klappen hervorragend. Und die meisten HDR10-Filme waren bisher für 1000 cd/m² ausgelegt. Insofern klappt es bei ihm mit sehr vielen Filmen sehr gut. Selbst bei Filmen mit 2000 cd/m², die also etwas über sein Maximum hinausgehen, wird das noch halbwegs ordentlich aussehen. Erst bei Filmen mit 4000 cd/m² oder mehr wird es dann auch für ihn schwer. Die sind zur Zeit aber noch recht dünn gesät, werden aber mit Dolby Vision vermehrt kommen, weil die allesamt meines Wissens für mindestens 4000 cd/m² abgemischt sind. Bei OLED passiert das aber bei allen Filmen, die über 500 cd/m² hinausgehen. Und da alle HDR10-Filme bisher mit mindestens 1000 cd/m² gemastert sind, trifft es bei OLED also bei 100% aller HDR10-Scheiben zu, dass der Film nicht sauber ohne Tonemapping angezeigt werden kann. Wie schlägt sich nun Dolby Vision? Im Prinzip gibt es dort genau das gleiche Problem. Nur gibt es dort dynamische Metadaten. Das heißt die maximale Helligkeit muss nicht wie bei HDR10 schon am Anfang des Films für den ganzen Film vorgegeben werden, sondern kann Szene für Szene neu eingestellt werden. Das heißt der Film sagt selbst, in welchen Szenen welche maximale Helligkeit vorkommen wird Dann muss der TV nicht mehr raten, wann er die Dynamik wie verbiegt, sondern er kann sich Szene für Szene an den Angaben des Films orientieren. Wenn nun aber ein Film wie "Ich einfach unverbesserlich" in fast allen Szenen auch die volle Helligkeit abfordert, dann bringen dynamische Metadaten halt auch wieder nichts. Darum ist hier der Unterschied zwischen HDR10 und Dolby Vision so gering. Wenn aber der Film in großen Bereichen stockfinster ist, wie bei "Resident Evil" und nur in wenigen Szenen die volle Helligkeit abruft, dann bringen dynamische Metadaten tatsächlich was, weil dann der TV in den dunklen Szenen aufhellen kann (bzw. weniger abdunkeln muss). Das hat also alles gar nichts mit dem Format der HDR-Scheiben zu tun, sondern nur mit dem Tonemapping beim Abspielen, wenn der TV das nicht kann, was die Scheibe fordert. Kann er es, ist es völlig Wurst, ob HDR10 oder Dolby Vision oder HDR10+. "HDR10 ist eine absolute Katastrophe" wie im obigen Video gesagt wird, ist also Blödsinn. Es ist nur ein Problem für Geräte, die die geforderte Helligkeit nicht können. Dynamische Metadaten sind wie gerade gezeigt auch kein Allheilmittel. Auch sie bringen den TV ja nicht plötzlich dazu, dass er bessere Helligkeit kann. Sie ermöglichen nur, dass der TV in den dann als dunkel gekennzeichneten Szenen weniger "schlecht" sein muss. Tonemapping bedeutet dann aber trotzdem immer noch, dass gleiche Helligkeiten im Film in unterschiedlichen Szenen unterschiedlich hell dargestellt werden, je nach Mapping in dieser Szene. Also alles andere als optimal und nicht das, was eigentlich erreicht werden soll, nämlich dass endlich die "korrekten" Helligkeiten angezeigt werden. Und vom TV generierte dynamische Verfahren wie "Active HDR" sind halt auch nur ein Kompromiss, der sich oft in schwankenden Helligkeiten sichtbar machen wird. Ob man das dann besser oder schlechter als eine der anderen drei Kompromisslösungen findet, das ist dann wirklich Geschmacksache. Bei einem Shootout, wo man vermutlich Szene für Szene den Film anhand von Standbildern vergleicht, da mag das noch recht gut wirken. Aber wenn der Film dann in normalem Tempo läuft und dann ständig die Helligkeit pumpt, dann ist das auch nicht mehr so toll.

Und aus den genannten Gründen ist es eben genau *nicht* sinnvoll, dem Zuschauer da keine Wahl mehr zu überlassen. Zumindest so lange die TV-Geräte die geforderte Helligkeit nicht liefern können. Dann sollte er zumindest die Wahl haben, welcher Kompromiss zur Anzeige genutzt wird. Wenn dann mal alle Anzeigegeräte 10.000 nits können, dann können wir darüber reden, ob man die Einstellmöglichkeiten wieder wegnimmt. Oder zumindest einen "Originalmodus" etabliert, der eben nichts mehr verstellt und rumrechnet. Bis dahin machen aber Einstellmöglichkeiten durchaus Sinn, um den notwendigen Kompromissen beim Tonemapping entgegen wirken zu können. Gruß, Hagge [Beitrag von hagge am 15. Aug 2017, 08:10 bearbeitet] |

||||||

|

norbert.s

Hat sich gelöscht |

#173

erstellt: 15. Aug 2017, 06:05

|

|||||

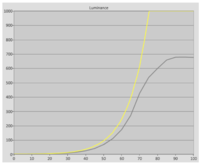

Du brauchst hier gar nichts zu behaupten, da die Transferkurven allesamt bereits nachgemessen wurden (für HDR10). Da haben wir es also bereits Schwarz auf Weiß. Die übliche Transferkurve für Master mit 1000 Nits (bei LG ab einem Softwareupdate bei den 2016er) lässt unten herum bis ca. 200-400 cd/m² alles "original". Erst darüber wird ein Soft-Clipping" durchgeführt. Da unten herum ist also nichts zu dunkel. Diverse optionale Bildeinstellungen für abweichendes Verhalten lasse ich einmal außen vor (z.B. Active HDR, Dynamischer Kontrast, Sony-spezial usw) und mangels Messbarkeit auch DV. Typisch für LG und Panasonic 1000:   Dort wo es darauf ankommt und was Klipsch-RF7II meint, dort sind die Master auf 1000 Nits einfach durchaus HDR-typisch relativ zu SDR recht dunkel abgemischt. Bei Master auf 4000 Nits wird es dann windiger. Panasonic hält die Transferkurve weiter, LG verlässt sie unten herum. Bei DV wird es komplizierter. Das ist hier auch das Thema vom Thread. Servus [Beitrag von norbert.s am 15. Aug 2017, 07:52 bearbeitet] |

||||||

|

Chris3636

Inventar |

#174

erstellt: 15. Aug 2017, 07:24

|

|||||

|

Also wie ich das verstanden habe gelten Helligkeitsspitzen bis zu 10000nits. Die meisten Filme werden aber zur Zeit mit 1000 nits oder mit 4000nits gemastert. Beispiel am Panasonic EZW1004 optimal für 4000 nits Hdr Filme. Das heißt doch nur das die Helligkeit auf der Grautreppe verschoben wurden ist und das absolute Weiß bei 4000 nits ist. Da stellt der Tv das HDR Bild richtig da, nichts ist zu dunkel. Dann treten keine großen Unterschiede zu Dolby Vision mehr auf. Bei 1000 nits Filme hat der Tv so seine Probleme, da die Grautreppe das absolute weiss bei 4000 nits hat. Und nicht bei 1000 nits. So hier müsste die Grautreppe anhand von einer Kalibrierung wieder neu eingestellt werden, sodaß der Weiß Wert in der Grautreppe bei 1000 nits liegt. Somit wären die Filme auch wieder nicht zu Dunkel. Jetzt meine Frage an alle erfahrenen Kalibrierer: Ist das so richtig? Wenn das der Fall ist müsste doch nur der Tv auf 4000 nits und auf 1000 nits Filme richtig kalibriert sein, und schon hätte mein kein Bild das zu dunkel ist. Und theoretisch brauchte man zur Zeit kein Dolby Vision mehr. |

||||||

|

norbert.s

Hat sich gelöscht |

#175

erstellt: 15. Aug 2017, 07:38

|

|||||

|

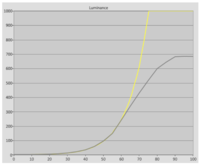

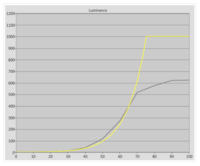

Der Geräte haben bereits unterschiedliche Transferkurven für 1000 und 4000 integriert. Je nach dem was die statischen Metadaten des Mediums an Information liefern. Mit 1000 gibt es definitiv weniger "Probleme" als mit 4000, da der Fernseher trotzdem so oder so nur um die 700 kann und bei 4000 das Soft-Clipping logischerweise früher losgehen muss, wenn man bis 4000 ein Hard-Clipping vermeiden will. Panasonic 1000:  Die offizielle Referenzkurve ST.2084 PQ EOTF wird bis ca. 400 eingehalten. Panasonic 4000:  Die offizielle Referenzkurve ST.2084 PQ EOTF wird bis ca. 300 eingehalten. LG 1000:  Die offizielle Referenzkurve ST.2084 PQ EOTF wird bis ca. 400 eingehalten. LG 4000:  Die offizielle Referenzkurve ST.2084 PQ EOTF wird gar nicht eingehalten. Hier versagt der LG. Update ist denkbar. DV ist momentan aufgrund der Dynamik der Transferkurve nicht messbar. Alle Grafiken gelten für HDR10. Servus [Beitrag von norbert.s am 15. Aug 2017, 08:06 bearbeitet] |

||||||

|

hagge

Inventar |

#176

erstellt: 15. Aug 2017, 08:11

|

|||||

Also bedeutet das, dass die LG-Leute vor dem Software-Update vielleicht Möglichkeit 1 gewählt hatten. Nachdem sich viele Leute beschwert haben, dass der Film zu dunkel ist, haben Sie auf Möglichkeit 2 gewechselt. Also alle hellen Stellen werden geclipped, aber zumindest kann nun niemand mehr sagen, dass die dunklen Stellen zu dunkel sind. Und weil das ganz offensichtlich auch nicht optimal war, haben sie nun 2017 als weitere Alternative Active HDR eingeführt, also Möglichkeit 4. Und immer noch kann ich nicht sehen, dass ich irgend etwas Falsches gesagt hätte. OK, ich hätte vielleicht "ich vermute letzteres" und nicht "ich behaupte letzteres" sagen sollen. Gut, habe ich korrigiert.

Dann soll es aber so sein. Dann ist der Film nicht in HDR zu dunkel, sondern war früher bei SDR zu hell. Was ja auch logisch ist. Wenn sich in einem Film viel bei unter einer gewissen Helligkeitsschranke, sagen wir mal 0,1 cd/m² abspielen soll, dann hat man bei SDR nur noch eine Handvoll Helligkeitsstufen zur Verfügung. Die reichen aber nicht mehr, um alle Details darzustellen. Also musste man zwangsweise oft solche dunklen Szenen aufhellen, damit man wenigstens ein paar mehr Helligkeitsstufen bekommt. Bei HDR hat man aber auch genug Helligkeitsstufen, ohne dass man aufhellen muss. Folglich ist der Film *dann* tatsächlich so, wie es ursprünglich gedacht war. Gruß, Hagge |

||||||

|

HicksandHudson

Inventar |

#177

erstellt: 15. Aug 2017, 08:15

|

|||||

|

Es zählt bei den meisten Leuten aber im Endeffekt nur der persönliche Eindruck und wenn jemand es nicht gut findet, dass ein Film auf HDR dunkler ist als auf Blu Ray, dann kann ich verstehen, dass das enttäuschend ist.....da bringt es auch nix, wenn es so "original" ist oder "richtig". Es muss "gut aussehen" für einen selbst und angenehm für die Augen sein. Die Mehrheit empfindet HDR10-Filme für zu dunkel und Dolby Vision schafft hier zumindest Abhilfe. |

||||||

|

norbert.s

Hat sich gelöscht |

#178

erstellt: 15. Aug 2017, 08:35

|

|||||

In keiner Weise. So war es vorher:

Ich habe nur gemeint, dass es statt Behauptungen auch Fakten gibt. Diese Fakten belegen vieles was Du schreibst und teilweise wird auch einiges widerlegt.

Auch hier wieder Halbe/Halbe von Dir. ;-) SDR ist vom Mastering üblicherweise für einen Weißpunkt von 100 cd/m² und Gamma 2.4 ausgelegt. Würden das alle User auch einstellen, dann wäre es auch hier vielen Usern ebenso zu dunkel wie bei HDR. Bei HDR wird mit absoluten Leuchtdichten gearbeitet und natürlich besteht mehr Luft nach unten. Diese Luft wird beim Mastering auch ausgenutzt und sogt für zusätzlichen Anpassungswunsch beim Endverbraucher. Servus [Beitrag von norbert.s am 15. Aug 2017, 08:37 bearbeitet] |

||||||

|

George_Lucas

Inventar |

#179

erstellt: 15. Aug 2017, 08:41

|

|||||

Richtig. Aber damit ist doch der gemeine Nutzer völlig überfordert. Ich habe mal ein paar Messungen durchgeführt bezüglich HDR. Das Flächenweiß eines HDR-Bildsignals beträgt 100 Nits, alles darüber ist den so genannten Highlights vorbehalten. Ein 1000-Nits-Signal ist 10-mal so hell wie das Flächenweiß. Ein 4000-Nits-Signal sogar 40-mal so hell wie das Flächenweiß. Wenn ein TV tatsächlich eine Leuchtdichte von 4000 Nits besitzt, ist im Grunde alles soweit in Ordnung. HDR sieht prächtig aus. Besitzt ein TV aber nur eine Maximalhelligkeit von 500 Nits (cd/m²), beginnt das ganz große Dilemma zu Hause. Die Verhältnismäßigkeit zwischen Flächenweiß (100 Nits) zu Spitzenweiß (z. B. 1000) bleibt. Das Flächenweiß besitzt 10 % des max. Highlights. Um nun alle Bildinhalte eines 1000-Nits-Bildsignals auf einem 500-Nits-TV wiederzugeben, kommt das Flächenweiß nur noch auf 50 Nits (cd/m²). Bei einem 4000-Nits-Bildsignal gar nur auf 2,5 cd/m² (Flächenweiß). Auf dieses Flächenweiß baut die Gammakurve auf. Deshalb ist es doch kein Wunder, dass die meisten Nutzer HDR zu dunkel empfinden. Wie hagge schon richtig schreibt, müssen nun Kompromisse her. Anders kann am Tag bei Sonnenschein niemand TV gucken. Die Leuchtdichte des Flächenweiß wird erhöht, was am anderen Ende zu überstrahlenden Flächen führt. Wenn ich mich jetzt mal so im Bekanntenkreis umsehe - ein paar Heimkino-Freaks mit technischem Verständnis sind dabei - ist der allgemeine Tenor: "HDR ist viel zu dunkel". Bildinhalte Filme werden leider nicht in HDR gedreht. Üblicherweise werden Filme im X, Y, Z - Farbmodell gedreht. Anschließend beginnen Bildbearbeitung und Mastering. Am Ende kommt ein Digital Intermediate (DI) heraus, das den Farbraum DCI-P3 und 10 - 12 Bit Quantisierung nutzt. So sehen wir den Film im Kino. - mit allen Bildinformationen. Für HDR (egal welche Variante) wird dieses DI verwendet, um daraus für den Heimmarkt eine entsprechende Variante zu "basteln". Dafür werden viele Bildinhalte dunkler dargestellt. Andere werden den so genannten Highlights zugeordnet. Irgendein Wert ist dann das Flächenweiß. Es bleiben also alle Bildinformationen zum größten Teil erhalten. Für SDR wird eine 8-Bit-Quantisierung genutzt und das kleinere Rec.709-Farbmodell genutzt. Es gehen also Bildinformationen vom DI verloren. Je nach Mastering fällt das mehr oder weniger auf. Das ergibt sich aus dem Umstand, dass SDR in der Regel nur 220 Grau/Farbabstufungen nutzt, während das DI über bis zu 4096 Grauabstufungen im selben Bildsignal verfügt. Je nach Filminhalt werden nicht immer max. Schwarz und max. Weiß verwendet, sondern eine begrenzte Anzahl davon, so dass ein SDR-Film bereits (fast) alle im DI vorhandenen Bildinformationen weitgehend darzustellen vermag. Das Problem TV Wenn nun der Nutzer Kompromisse eingeht, weil ein HDR-Signal aufgrund der TV-Limitierungen ansonsten zu dunkel dargestellt wird - und Bildinhalte infolgedessen für eine höhere Lichtausbeute wegfallen - kann es durchaus passieren, dass ein TV mit einem SDR-Film mehr Bildinhalte besitzt als ein nicht vollumfänglich dargestellter HDR-Film. Zu Dolby Vision und HDR im Allgemeinen Ich finde den erweiterten Farbraum großartig, ebenso eine Quantisierung von 10 Bit und eine höhere Auflösung. HDR/Dolby Vision empfinde ich als überflüssig. Warum werden dem TV-Besitzer nicht alle Bildinformationen zur Verfügung gestellt - also so wie im DI mit 10 Bit und erweitertem Farbraum - und der TV-Besitzer kann die Helligkeit wunschgemäß so regeln, wie es die Lichtumgebung zu Hause erforderlich macht. Das wäre einfach und jeder TV-Besitzer wäre zufrieden. [Beitrag von George_Lucas am 15. Aug 2017, 08:52 bearbeitet] |

||||||

|

norbert.s

Hat sich gelöscht |

#180

erstellt: 15. Aug 2017, 11:48

|

|||||

Welche Kiste hast Du denn gemessen? Denn genau dieses Szenario (hagge: Möglichkeit 1) wird von Ausnahmen abgesehen nicht angewandt. Wie ich oben bereits dargelegt habe, wird üblicherweise die Transferkurve ST.2084 PQ EOTF bis ca. 200 bis 400 cd/m² eingehalten um darüber dann den "eigenen" Weg des von der Leuchtdichte limitierten Fernsehers zu gehen. Damit wird auch das Flächenweiß eingehalten. Den allgemeinen Eindruck, dass HDR überwiegend "zu dunkel" wirkt kann ich bestätigen. Das liegt aber nicht an einem Fernseher, der die unteren paar hundert Candela korrekt abbildet, sondern am Mastering. Dabei lasse ich die Situation "am Tag bei Sonnenschein" außen vor, weil dort wird es immer so oder so "zu dunkel" wirken, wenn man keine Anpassung für diese Umgebungsparameter vornimmt. Ausnahmen bestätigen die Regel, so wie oben die Transferkurve des 2017er LG OLED bei einem Master mit 4000 Nits. Da ist es tatsächlich doppelt gemoppelt - Master dunkel, Fernseher zu dunkel - per Default bei der Kiste "Möglichkeit 1". ;-) Natürlich beinhaltet meine Erläuterung auch die Tatsache, dass es logischerweise bei über ca. 200 bis 400 cd/m² weniger hell wird, als bei einem Fernseher, der die Transferkurve ohne Limitierungen weiter korrekt ein halten kann. Thema Soft- und Hardclipping. Nur ist das nicht das was die User als "zu dunkel" beschreiben. Da geht es dann nicht mehr um "zu dunkel", sondern um "welche Kiste hat mehr Power" für die Spitzenlichter. ;-) Servus |

||||||

|

George_Lucas

Inventar |

#181

erstellt: 15. Aug 2017, 12:54

|

|||||

Hier möchte ich noch ergänzen, dass die 100 cd/m² und Gamma 2.2 erst festgelegt worden sind, nachdem HDR spezifiziert und (von vielen) als zu dunkel deklariert worden ist. Also hat die Industrie schnell eine Standard-Anpassung vorgenommen für das Flächenweiß von SDR. Nur interessiert dieser neue SDR-Helligkeits-Standard niemanden im Wohnzimmer. Wenn tagsüber die Sonne scheint, wird die Hintergrundbeleuchtung hochgedreht. Da abends kaum jemand die Leuchtdichte händisch reduziert, wird im Raum noch eine Lampe eingeschaltet. So funktioniert das Nutzerverhalten beim Fernsehen seit Jahren. Bei HDR ist das so (leider!) nicht möglich, weil die technischen Leuchtdichte-Beschränkungen des TV-Gerätes das verhindern. Den großen Vorteil von Dolby Vision sehe ich an einer ganz anderen Stelle. Während HDR-10-Kontent maximal 880 Grauabstufungen mit einer 10-Bit-Quantisierung darzustellen vermag (Y = 64 - 940), werden es bei Inhalten, welche nicht das volle Leuchtdichtespektrum ausschöpfen entsprechend weniger Abstufungen sein, weil bei statischen Metadaten die Anpassung nur einmal erfolgt. Dolby Vision kann zwar auch nur maximal 880 Grauabstufungen darstellen mit der 10-Bit-Quantisierung. Mit der dynamischen Anpassung ist DV allerdings imstande, die vollen 880 Grauabstufungen in allen Szenen zu nutzen. Das führt am Ende zu sichtbar weniger Banding-Effekten, weil die Abstufungen in Farbverläufen deutlich feiner ausfallen können. [Beitrag von George_Lucas am 15. Aug 2017, 12:55 bearbeitet] |

||||||

|

norbert.s

Hat sich gelöscht |

#182

erstellt: 15. Aug 2017, 14:04

|

|||||

Das Thema Gamma 2.2 versus Gamma 2.4 sorgt immer wieder für Verwirrung. Die 100 cd/m² und Gamma 2.4 (bzw. EBU recommendations 2.35) wurde mit HDTV und Rec.709 lange vor HDR als Empfehlung festgelegt.  http://www.hifi-foru...=59&postID=6069#6069 http://www.hifi-foru...=59&postID=6069#6069Die Story ist aber weitaus komplexer durch die Umstellung der Studiomonitore von Röhre auf LCD auf OLED:  http://www.hifi-foru...3&postID=10618#10618 http://www.hifi-foru...3&postID=10618#10618

Servus |

||||||

|

hagge

Inventar |

#183

erstellt: 15. Aug 2017, 14:31

|

|||||

Ist das wirklich so? Das würde doch bedeuten, dass es eine eigene PQ-Kurve für jeden möglichen maximalen Helligkeitswert gibt. Denn jede Szene kann ja über die dynamischen Metadaten einen anderen maximalen Helligkeitswert festlegen und über die PQ-Kurve erfolgt dann die EOT-Funktion. Das glaube ich aber ehrlich gesagt nicht. Ich denke es gibt auch bei DV nur eine einzige PQ-Kurve. Und es passiert das gleiche wie bei HDR10. Wenn in einem Film (bei DV entsprechend in einer Szene) eben nur Werte von 0 bis 100 cd/m² vorkommen, dann bleiben die höheren Werte einfach ungenutzt. Ich glaube nicht, dass dann eine feinere Auflösung möglich ist und die höheren Werte wieder genutzt werden. Bei HDR10 ist es z.B. so, dass die Abbildung über die PQ-Kurve immer gleich ist. Und die ist bis 10.000 cd/m² definiert. Wenn also eine BD nur auf 1000 cd/m² abgemischt ist, werden die höheren Werte einfach nie auf dieser Scheibe vorkommen. Gruß, Hagge [Beitrag von hagge am 15. Aug 2017, 14:34 bearbeitet] |

||||||

|

norbert.s

Hat sich gelöscht |

#184

erstellt: 15. Aug 2017, 14:38

|

|||||

Wenn wir hundert Nutzer haben, dann haben wir hundert unterschiedliche Vorlieben. :-) Daher ist es erst einmal wichtig für den Fernseher und für das Medium, dass die Standards korrekt eingehalten werden - egal ob HDR oder SDR. Auf dieser Basis kann dann jeder Nutzer seine Vorlieben einstellen. Wie Du richtig schreibst ist das bei SDR gang und gäbe. Bei HDR ist der Weg zu mehr Flexibilität auch bereitet, da die Fernseher die ich kenne bereits verschiedene Transferkurven als HDR-Bild Modi für verschiedene Umgebungsbedingungen bieten. Übersichtlicher wird es dadurch nicht unbedingt, da manche Kisten die akkurateste Wiedergabe als Kino-Mode, andere als Standard-Mode benennen. Aber wie Du erkannt hast, hat ja bei SDR schon jeder Ottonormalverbraucher eingestellt was ihm gefällt und bei HDR wird das sicherlich auch (bald) möglich sein. ;-) Ich habe theoretisch bei UHD-Player und Fernseher 3x3 HDR-Modi zur Verfügung. Ergibt schon 9 Kombinationen ohne Dynamischen Kontrast, Active HDR oder DV. ;-) Servus [Beitrag von norbert.s am 15. Aug 2017, 14:45 bearbeitet] |

||||||

|

George_Lucas

Inventar |

#185

erstellt: 15. Aug 2017, 14:51

|

|||||

|

@norbert.s Meines Wissens liegt hier ein Fehler in Wikipedia vor. Die ITU hat damals bei der Spezifikation von Rec.709 schlichtweg vergessen, das Gamma für die Wiedergabe zu spezifizieren, während sie es aufnahmeseitig festgeschrieben hat. Später hat sich das "lineare" Gamma 2.2 allgemein durchgesetzt, weil es von Industrie und Handel einfach verwendet wurde. Es gab damals viele Probleme diesbezüglich, weil sich der Helligkeitsanstieg von Gamma Rec.709 aufnahmeseitig und das allgemein verwendete Gamma wiedergabeseitig unterscheiden. Hier die aktuelle Spezifikation von 2015:  ITU-Rec709 ITU-Rec709Darin ist ein Gamma 2.4 nicht festgeschrieben, wenn ich das richtig verfolgt habe. Andere Institutionen wie zum Beispiel THX (Gamma 2.4) haben eigene Standards entwickelt, die bis heute auch genutzt werden. THX stellt dabei sogar einen Sonderfall dar, weil die Videorange (Superwhite) Y = 16 - 255 für Displays vorgegeben sind, gleichwohl sogar die THX standardisierten Filme auf DVD/Blu-ray die Videorange Y = 16 - 235 verwenden. Auf Nachfrage konnte mir niemand bei THX den Sinn in diesem Widerspruch erklären. Sollte es inzwischen Änderungen geben, lasse ich mich gerne korrigieren. [Beitrag von George_Lucas am 15. Aug 2017, 14:52 bearbeitet] |

||||||

|

norbert.s

Hat sich gelöscht |

#186

erstellt: 15. Aug 2017, 15:17

|

|||||

Da hat sich seit 1993 nichts geändert. Ausgabeseitig musste es nicht festgeschrieben werden, da alle (Studio und Wohnzimmer) über Röhre geschaut haben mit einem festen Gamma, welches bei allen in etwa gleich war. Andere - nicht die ITU - haben das später nachgeholt, als es in der "Moderne" am Gerät einstellbar wurde. Ich würde die EBU hier nicht ignorieren wollen. Du solltest schon  den zweiten Link oben auch nachlesen. Ich konnte bei meiner damaligen Recherche 2014 die Angaben von Koji-X nachvollziehen und weitestgehend bestätigen. den zweiten Link oben auch nachlesen. Ich konnte bei meiner damaligen Recherche 2014 die Angaben von Koji-X nachvollziehen und weitestgehend bestätigen.Nicht umsonst sage selbst ich auf die Frage, was denn das richtige Gamma wäre: Alles zwischen Gamma 2.2 und 2.4 ist nicht falsch. ;-) Achja - hier noch abschließend die EBU Tech 3320 (first issued 2007): It has been found from measurement techniques, progressively refined over several decades, that a correctly designed CRT display has an EOTF gamma of approximately 2.35 [5]. This is part of the ‘immovable legacy effect’ of the CRT. In January 2014 a study was made at the IRT in Munich, comparing a variety of video material, and film material graded for video, on three monitors set for gamma values of 2.2, 2.35 and 2.4. An analysis of the comments and views of the vision engineers and colourists who took part in the study concluded that monitors set to 2.35 and 2.4 were so similar that no substantial difference would have occurred had the material been graded at one or other setting. The EBU has therefore taken the decision to drop its preference for a gamma of 2.35 to bring this document into line with other international standards bodies (who in general took the view that the value need only be specified to one decimal place), and the EBU are thus accepting a gamma value of 2.4... Aber das führt hier zu weit ins OT und möchte daher von meiner Seite enden. Servus [Beitrag von norbert.s am 15. Aug 2017, 16:11 bearbeitet] |

||||||

|

George_Lucas

Inventar |

#187

erstellt: 15. Aug 2017, 16:32

|

|||||

Na, dann sehen wir das ja weitgehend gleich. Für HDR wurde das Gamma ja nun verbindlicher spezifiziert. Wie du in deinen Messungen sehr eindrucksvoll aufzeigst, kocht hier leider (aber verständlicherweise) jeder TV-Hersteller sein eigenes Süppchen, in dem er vom standardisierten Gamma obenrum abweicht. Wirklich zielführend finde ich das alles aber nicht. |

||||||

|

George_Lucas

Inventar |

#188

erstellt: 15. Aug 2017, 16:57

|

|||||

So habe ich das damals in London verstanden, als ich von BenQ mit wenigen anderen Journalisten in das dortige Dolby Studio eingeladen war. Dort habe ich mich nach Dolby Vision genauer erkundigt - und bekam das als Antwort auf meine Frage.

Richtig. Der Player/TV bekommt zum Start einmalig die Metadaten - und stellt sich bei HDR-10 dann entsprechend ein. Das ist halt einer der Nachteile der statischen Metadaten. [Beitrag von George_Lucas am 15. Aug 2017, 16:58 bearbeitet] |

||||||

|

norbert.s

Hat sich gelöscht |

#189

erstellt: 15. Aug 2017, 17:16

|

|||||

Müssen sie ja auch zwingend, da keiner die 1000 cd/m² oder gar die 4000 cd/m² erreicht. Ohne Abweichung geht es dann nicht. Ein Standard für die Abweichung vom Standard ist nun wirklich zu viel verlangt. ;-) Ich habe da ein einfaches Kriterium für meinen nächsten OLED. Er muss im Fenster mindestens ca. 1400 cd/m² erreichen. Wieso? Damit er die ST.2084 PQ EOTF bis 1000 Nits korrekt einhalten kann und für die 4000 Nits eine kleine Reserve für das Soft-Clipping hat. Den kann ich dann behalten, bis der nächste OLED 5500 cd/m² erreicht. Wieso? Damit er die ST.2084 PQ EOTF bis 4000 Nits korrekt einhalten kann und für die 10000 Nits eine kleine Reserve für das Soft-Clipping hat. ;-) DV ist für Fernseher, die die geforderte Leuchtdichte erreichen (4000) die Krönung und für Fernseher, die die Leuchtdichte nicht erreichen eine adäquate Notlösung. Servus |

||||||

|

norbert.s

Hat sich gelöscht |

#190

erstellt: 15. Aug 2017, 17:27

|

|||||

So habe ich es auch verstanden. Es wird dynamisch per Metadaten die Leuchtdichte von Weiß- und Schwarzpunkt festgelegt und alle Bits können (müssen aber nicht) in diesem Leuchtdichte-Bereich dann benutzt werden. Das fand ich damals genial und sehr ambitioniert. Leider habe ich mir den Link dazu nicht aufgehoben. Damals hatte ich noch kein DV-Equipment daheim. Servus |

||||||

|

norbert.s

Hat sich gelöscht |

#191

erstellt: 16. Aug 2017, 10:34

|

|||||

|

Es ist gar nicht einfach dazu überhaupt Details oder eine Bestätigung im Internet zu finden. ...Well, with static metadata, the boundaries in brightness are set for the entirety of the movie. For example: If you set the boundary as 0 to 1000 cd/m2, the moment you enter a very dark scene where none of the colors reach above 50 cd/m2, only 5% of the bit depth will be available for use. With dynamic metadata, the boundary can be adapted to the scene. In the same scenario, the dark scene would have the full 10 bit distributed in the much smaller amount it needs...  http://www.rtings.com/tv/learn/hdr10-vs-dolby-vision http://www.rtings.com/tv/learn/hdr10-vs-dolby-visionServus |

||||||

|

norbert.s

Hat sich gelöscht |

#192

erstellt: 18. Aug 2017, 08:08

|

|||||

|

Nun geht es erst richtig los. :-) Der erste preiswerte UHD-Blu-ray-Player mit Dolby Vision:  Dolby Vision HDR Update für LG UHD Blu-ray Disc Player erschienen Dolby Vision HDR Update für LG UHD Blu-ray Disc Player erschienenServus |

||||||

|

hagge

Inventar |

#193

erstellt: 18. Aug 2017, 10:04

|

|||||

Eigentlich liest man überall, dass Dolby Digital (ST 2094-10) auch auf PQ (ST 2084) basiert. Dort bei ST 2084 wird aber gesagt, dass es eben keine unterschiedlichen Codierungen für unterschiedliche maximale Helligkeiten gibt, weil der Platz, der durch hohe Helligkeiten verschwendet wird, vergleichsweise gering ist. Siehe z.B. hier:  https://www.smpte.or...ller-1-2-handout.pdf auf Folie 14: Der Bereich von 5000 bis 10000 cd/m² verbraucht gerade einmal 7% des Codespaces. https://www.smpte.or...ller-1-2-handout.pdf auf Folie 14: Der Bereich von 5000 bis 10000 cd/m² verbraucht gerade einmal 7% des Codespaces.Ein theoretischer Vergleich, wie der Unterschied verschiedener Codierungen bei einer Gamma-basierten Codierung und bei der PQ-basierten Codierung aussähe, ist dann auf Folie 16 zu sehen, Dort sieht man den Anteil der entsprechenden Codeworte an der Gesamtmenge bei Codierung für 10000 cd/m2, 5000 cd/m², 2000 cd/m², 1000 cd/m² und 500 cd/m². Man sieht im Slide zu Gamma, dass man da viel Platz einsparen könnte, aber bei PQ eben gar nicht mehr viel. Das heißt aber für mich im Umkehrschluss, dass es wirklich nur eine einzige PQ-Quantisierungs-Codierung gibt und auch Dolby Vision dann diese Codierung nutzt. Und dann eben bei Szenen mit geringeren Helligkeiten *keine* höhere effektive Bittiefe durch eine andere Codierung nutzen kann. Gruß, Hagge |

||||||

|

HicksandHudson

Inventar |

#194

erstellt: 18. Aug 2017, 10:11

|

|||||

Wenn jetzt dann endlich mal viele Filme raus kämen auf Disc, dann könnte man fast anfangen, direkt zu vergleichen, wie viel DV wirklich bringt auf rein physischer Disc. [Beitrag von HicksandHudson am 18. Aug 2017, 10:12 bearbeitet] |

||||||

|

norbert.s

Hat sich gelöscht |

#195

erstellt: 18. Aug 2017, 10:39

|

|||||

|

@hagge Da ich aktuell nur eine einzige Quelle dazu im Internet gefunden habe, gehe ich auch erst einmal von deinem Szenario aus. Die andere Quelle finde ich nicht mehr. Ist aber auch schon über ein Jahr her. Grundsätzlich arbeitet Dolby Vision mit 12bit und HDR10 mit 10bit. So gesehen ist eine höhere Auflösung bei PQ EOTF kein Problem. Und um nichts anderes geht es - mehr Bits für einen definierten aber dynamischen Bereich der Transferkurve. Also kein Hexenwerk. Servus [Beitrag von norbert.s am 18. Aug 2017, 10:45 bearbeitet] |

||||||

|

hagge

Inventar |

#196

erstellt: 22. Aug 2017, 05:22

|

|||||

Naja, wenn im Standard z.B. eine 12-Bit-Codierung vorgegeben wird, kann man die 10-Bit-Variante einfach erhalten, indem man nur jeden vierten Wert nimmt. Genauer: Man erhält den zu nutzenden 12-Bit-Wert, indem man die höchstwertigen zwei der zehn Bits nochmal unten an die 10 Bits anhängt, 0000_0000_00 -> 0000_0000_0000Durch diesen gängigen Trick für Bittiefen-Umrechnung erhält man wirklich sauber alles von lauter 0-Bits bei dunkel zu lauter 1-Bits bei hell. Sofern hinter der Abbildung der PQ-Werte auf die Codeworte ein Algorithmus steckt, wäre es natürlich auch möglich, diese Berechnung dynamisch für jeden beliebigen Helligkeitsbereich abhängig von den gerade geltenden Metadaten zu machen. Insofern ist mir schon klar, dass so ein variables Vorgehen durchaus möglich wäre. Das würde aber genauso für HDR10 gelten, dann eben über den gesamten Film. Nur bei HDR10 wurde mir seinerzeit erklärt, dass sich dort die ungenutzten Helligkeiten eben auch in ungenutzten Codeworten manifestieren. Ob das wirklich stimmt -- keine Ahnung. Der Vortragende war aber sehr kompetent, insofern würde ich eher dazu tendieren, ihm zu glauben. Es kann auch sein, dass diese Umrechnung zwar grundsätzlich möglich, aber zu komplex für die Implementierung in Hardware und zu langsam für Software ist. Wir haben es bei 4K immerhin mit über 8 Mio Pixeln zu tun, die entsprechend oft pro Sekunde umgerechnet werden müssen. Wenn man darum nur mit einer Lookup-Tabelle arbeiten kann, wird so eine Dynamik wieder fast unmöglich. Vielleicht müsste man mal in den Quellcode zu ffmpeg schauen. Die können doch bestimmt schon HDR10, vielleicht sogar Dolby Vision. Gruß, Hagge [Beitrag von hagge am 22. Aug 2017, 05:31 bearbeitet] |

||||||

|

Henro

Stammgast |

#197

erstellt: 28. Aug 2017, 05:44

|

|||||

|

Ich habe gestern Fast and Furious 8 UHD mit dem LG UP970 Player an einem LG 55UH8509 geguckt. Das Bild gefiel mir wirklich ausgesprochen gut, jedoch habe ich die erste halbe Stunde die dynamische Hintergrundbeleuchtung immer wieder umgestellt, weil das Bild je nach Szene immer nachdunkelte oder nachhellte, bis ich auf "aus" gemerkt habe, dass der Effekt nicht verschwindet. Ist dieses Verhalten Dolby Vision zu "verdanken"? |

||||||

|

norbert.s

Hat sich gelöscht |

#198

erstellt: 28. Aug 2017, 06:50

|

|||||

|

Theoretisch - Ja. Wenn der Fernseher lahmarschig auf die dynamischen Metadaten reagiert ist durch den Zeitversatz ein Regelvorgang sichtbar. Servus |

||||||

|

yilhas

Stammgast |

#199

erstellt: 28. Aug 2017, 16:59

|

|||||

|

HicksandHudson

Inventar |

#200

erstellt: 28. Aug 2017, 19:46

|

|||||

|

Ohje....dass Pana da mit macht, hätte ich nie gedacht. Das könnte das ganze HDR Thema ziemlich durcheinander schmeißen und für DV blöd ausgehen. |

||||||

|

BigBlue007

Inventar |

#201

erstellt: 28. Aug 2017, 20:47

|

|||||

|

Das wird es definitiv. Es war ja vorher schon abzusehen, dass sich DV nicht als HDR-Standard durchsetzen wird - dazu ist Samsung zu groß und die Verlockung für alle anderen, dass mit HDR10+ eine lizenzkostenfreie Alternative bereitsteht, ebenso. Panasonic dürfte nur der erste Hersteller neben Samsung sein, der auf den Zug aufspringt. Andere werden folgen. DV ist spätestens seit heute zum Tode verurteilt. Das Gute daran ist, dass sich jeder, bei dem eine Kaufentscheidung bevorsteht, nun nicht mehr darum kümmern muss, ob das gewünschte Gerät DV kann oder können wird. Das Blöde ist, dass man jetzt halt wissen müsste, wer noch alles bei HDR10+ mitzieht...  Oder das Ganze ist einem im Moment halt einfach erstmal noch Latte...  [Beitrag von BigBlue007 am 28. Aug 2017, 20:48 bearbeitet] |

||||||

| ||||||

|

|

||||

| Das könnte Dich auch interessieren: |

|

HDR 10+, Dolby Vision PeterHimmel am 20.08.2020 – Letzte Antwort am 01.12.2022 – 18 Beiträge |

|

Dolby Vision und HDR gehört die Zukunft V._Sch. am 25.07.2015 – Letzte Antwort am 29.09.2015 – 208 Beiträge |

|

Unterschied Dolby Vision und Dynamisches HDR (HDMI2.1)? fe0109 am 29.08.2018 – Letzte Antwort am 18.11.2020 – 11 Beiträge |

|

Verständnisfragen: LG Active HDR - HDR HLG -Dolby Vision htpc4ever am 18.11.2017 – Letzte Antwort am 06.03.2018 – 12 Beiträge |

|

Apple TV 4K & Sony A8 Dolby Vision Set Up CopaMike am 23.09.2018 – Letzte Antwort am 02.10.2018 – 3 Beiträge |

|

Hue Sync Box + Xbox Series X kein Dolby Vision? [GELÖST] DarthSonic am 01.06.2021 – Letzte Antwort am 02.06.2021 – 2 Beiträge |

|

Hue Sync Box nur Dolby Vision Low Latency? DarthSonic am 28.09.2021 – Letzte Antwort am 01.05.2022 – 4 Beiträge |

|

Nvidia 3D Vision Erfahrungsbericht qfactor am 06.11.2010 – Letzte Antwort am 21.11.2010 – 6 Beiträge |

|

Vision eines Fernsehers Malte_ am 13.08.2015 – Letzte Antwort am 17.08.2015 – 18 Beiträge |

|

Toshiba Super High Vision Display ? duno am 21.05.2011 – Letzte Antwort am 24.05.2011 – 3 Beiträge |

Anzeige

Produkte in diesem Thread

Aktuelle Aktion

Top 10 Threads in Neue Technologien der letzten 7 Tage

- Govee WLAN TV | /Ambilight) Beleuchtung Kit mit Kamera

- Philips Hue Sync Box - potentielle Lösung für Probleme bei der Lichtsynchronisation

- Unterschied HDR10+ und HDR10 Pro

- Der allgemeine Heim-3D-Thread

- Govee Geräte mit zwei Handy´s steuern ?

- Verständnisfragen: LG Active HDR - HDR HLG -Dolby Vision

- Farbtiefe; Deep Color und 12bit

- Amazon Prime Video auf Panasonic TV

- Am Beamer besser 3D H-SBS oder H-OU ?

- Unterschied Dolby Vision und Dynamisches HDR (HDMI2.1)?

Top 10 Threads in Neue Technologien der letzten 50 Tage

- Govee WLAN TV | /Ambilight) Beleuchtung Kit mit Kamera

- Philips Hue Sync Box - potentielle Lösung für Probleme bei der Lichtsynchronisation

- Unterschied HDR10+ und HDR10 Pro

- Der allgemeine Heim-3D-Thread

- Govee Geräte mit zwei Handy´s steuern ?

- Verständnisfragen: LG Active HDR - HDR HLG -Dolby Vision

- Farbtiefe; Deep Color und 12bit

- Amazon Prime Video auf Panasonic TV

- Am Beamer besser 3D H-SBS oder H-OU ?

- Unterschied Dolby Vision und Dynamisches HDR (HDMI2.1)?

Top 10 Suchanfragen

Forumsstatistik

- Registrierte Mitglieder930.696 ( Heute: )

- Neuestes Mitglied

- Gesamtzahl an Themen1.563.569

- Gesamtzahl an Beiträgen21.829.326